Qwen3 开源了!不只是开源模型,连部署文档都一并放出——本地跑通不再是高门槛挑战。本文将带你用最低成本尝鲜 Qwen3 本地部署,实测小模型能力边界,并拆解背后的开源策略与使用感知。

Qwen3 通过 混合推理架构和分层参数激活策略,在性能超越 DeepSeek-R1 的同时实现成本与效率的颠覆性突破,尤其适合需要平衡性能与资源的场景。

趁着刚刚发布的千问3,赶快本地部署一下,体验一吧

本地化部署开始:

用ollama工具

笔记本电脑:轻薄本,win11系统,核显

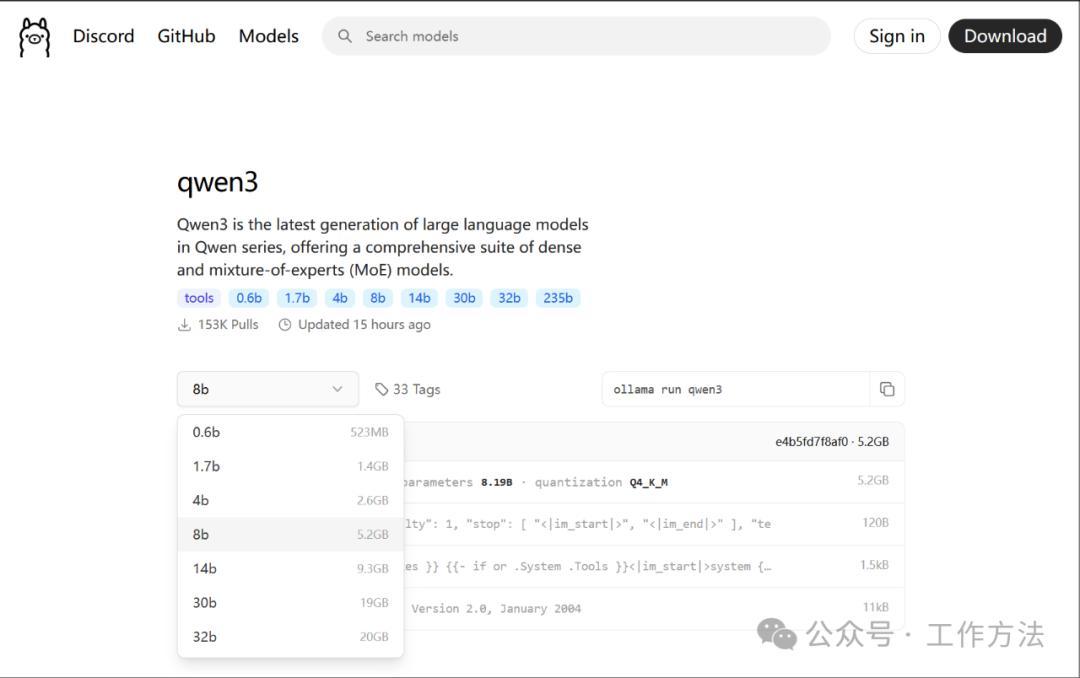

第一步:选择模型版本

ollama官网:

https://ollama.com/library/qwen3

我这里用个最小的“qwen3:0.6b”小模型演示

第二步:确认本机已经安装ollama;参考部署deepseek文章:deepseek-r1模型本地化部署+联网搜索【教程】

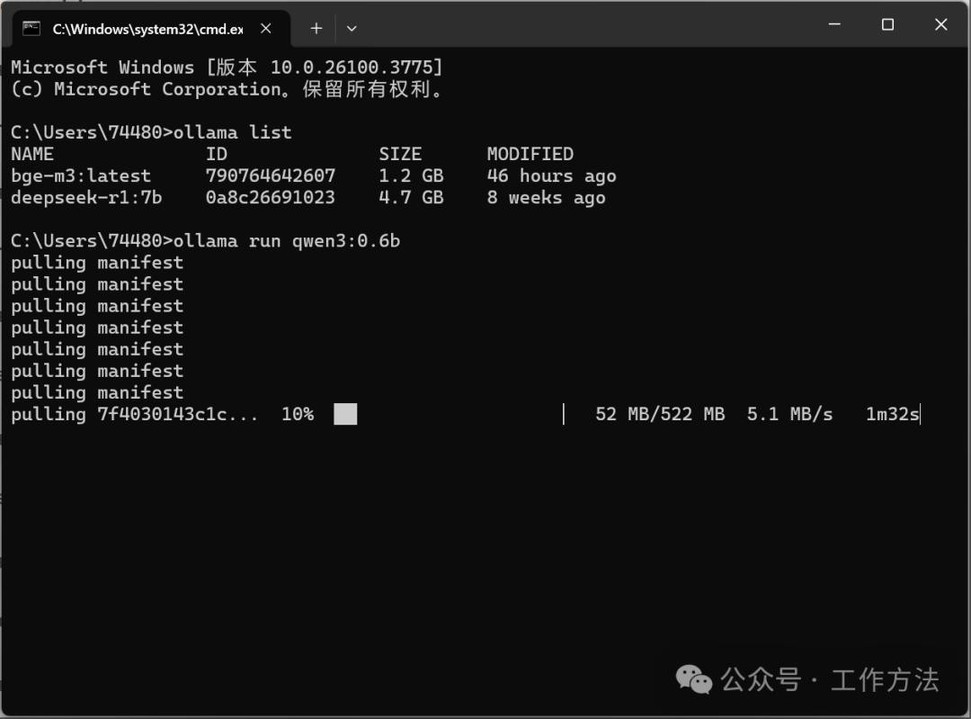

第三步:安装模型

win+r,打开命令提示符输入

ollamarun qwen3:0.6b

用ollama安装qwen3:0.6b模型

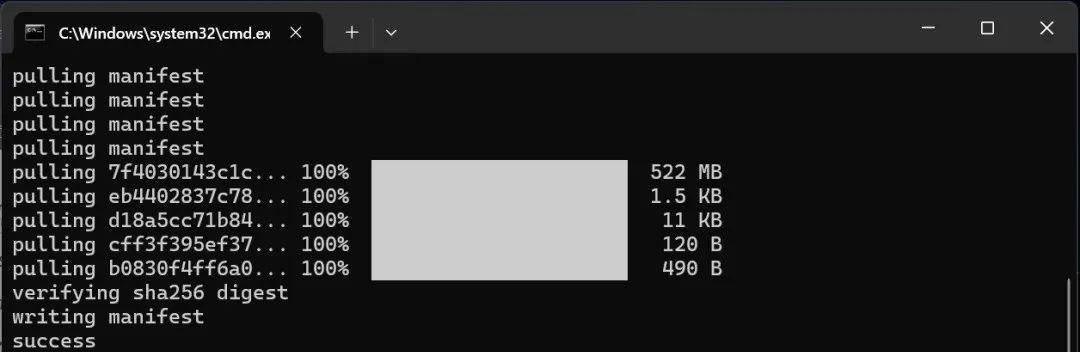

等待几分钟,

安装完成

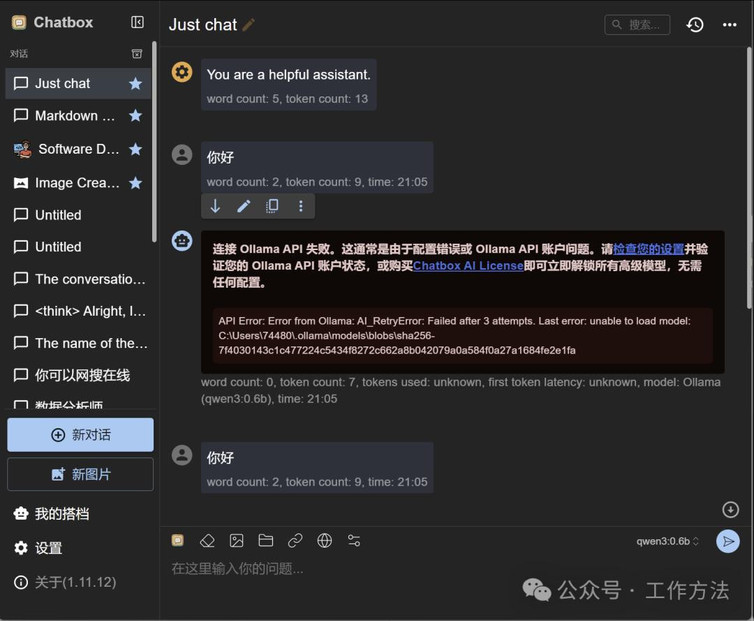

第四步:chatbox设置

打开chatbox详细安装过程,参考deepseek-r1模型本地化部署+联网搜索【教程】

用chatbox设置模型

现在可以使用了~

直接在chatbox中提问就可以了~

异常情况:

如果按照设置出现报错,👇

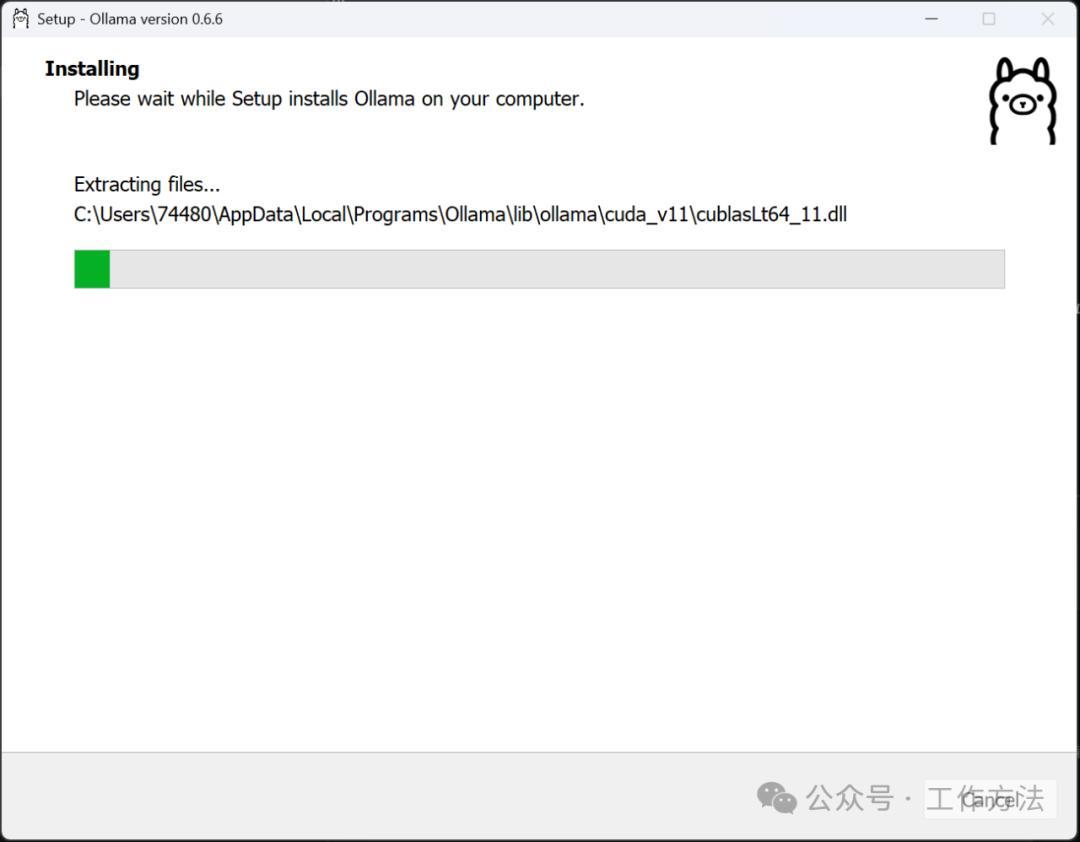

检查ollama版本,因为千问新开源的模型,旧版本ollama无法驱动,需要升级一下就可以,

升级完成就可以。

本文由 @董方旭 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务