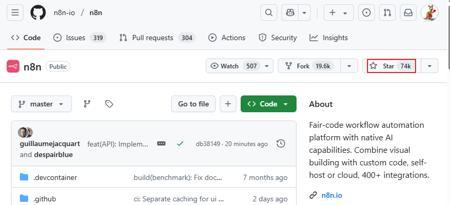

给大家安利一个在GitHub已经有75K 超高Star的开源workflow平台:n8n

GitHub地址:

https://github.com/n8n-io/n8n

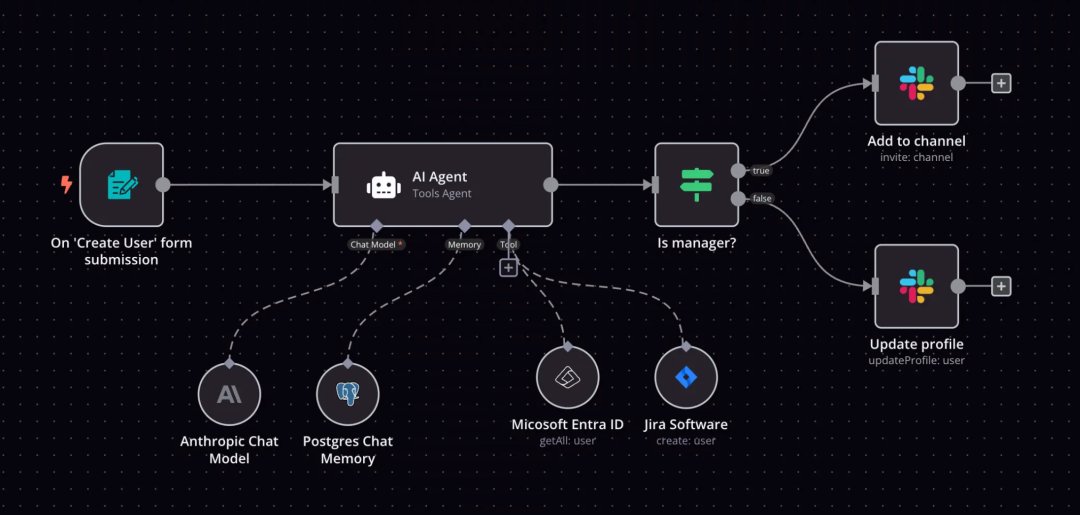

它跟fastgpt、dify、coze等LLM平台略有不同,n8n是专注workflow(工作流)这块的。可以集成LLM,但不限于此,可以更自由的定制AI流程。

最大的区别就是n8n的工作流节点更丰富,支持更加细粒度的配置,自由度更高,功能更强大

所以就workflow而言,n8n是绝对的专业、强大。

分享一个个人观点,虽然那种让AI自己边干活边思考的模式很棒,更省力,但使用下来,我觉得现阶段还存在很多问题,最大的问题就是不稳定,复杂任务成功率低。所以目前很多场景我还是推荐定制固定的工作流,因为这本身就是用来增加AI系统稳定性的

它可以把各种互不相关的系统和API连接起来(官方提供了400+各种工具和应用的节点)

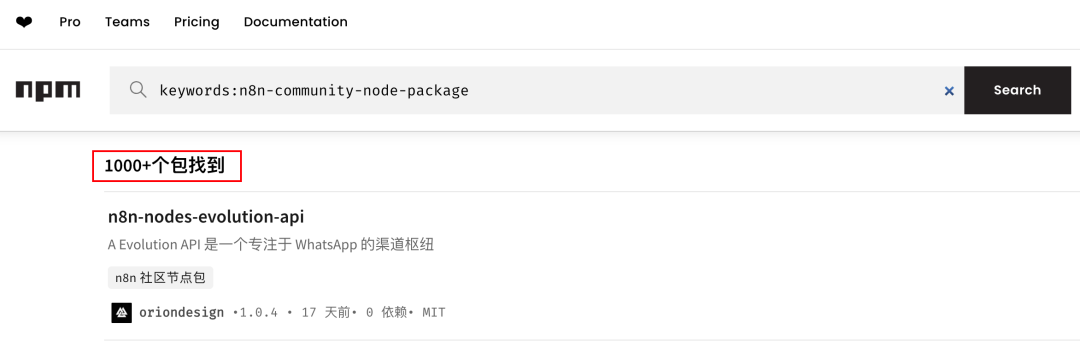

另外,社区还提供了1000+外部工具、应用,让数据在不同服务之间自由流动。它所支持的工具甚至比字节的扣子还要丰富。

还内置丰富的AI节点

轻松整合DeepSeek等各大厂商的模型,定制专属AI Agent

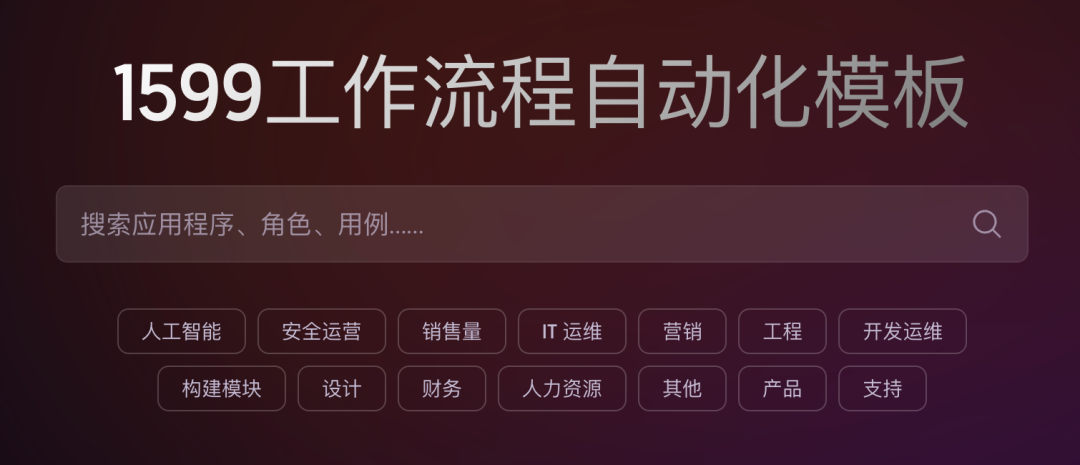

当然,你也不必任何功能都自己吭哧吭哧搭建,官方支持1599个现成的工作流模板,涵盖各种实用场景,咱们可以找到合适的直接复制过来用,或者在模板基础上构建自己的工作流。

可以说在n8n上,几乎任何定制化需求都可以得到满足,更关键的是:它的可视化界面设计得非常直观。即使你不是技术人员,也能通过拖拽节点的方式,轻松创建复杂的工作流。

另外官方虽然还未支持MCP,但社区已经提供了MCP节点(这块将在后续文章详细讲解)

还支持企业级的权限管理:SSO,RBAC权限控制;

企业级功能:版本控制,追溯回滚,日志追踪等。

n8n快速部署

安装n8n还是比较简单的,通过docker即可一键部署

它只需要启动一个服务(镜像也只有700多M),相比fastgpt,dify等需要的资源更少,对电脑配置基本没啥要求

docker volume create n8n_datadocker run -d --name n8n -p 5678:5678 \-v n8n_data:/home/node/.n8n \-e N8N_SECURE_COOKIE=false \-e N8N_HOST=你的外网IP \docker.n8n.io/n8nio/n8n

或者也可以使用docker-compose.yml

version: "3"services:n8n:image: docker.n8n.io/n8nio/n8ncontainer_name: n8nports:- "5678:5678"volumes:- n8n_data:/home/node/.n8nenvironment:- N8N_SECURE_COOKIE=false- N8N_HOST=你的外网IPrestart: unless-stoppedvolumes:n8n_data:external: true

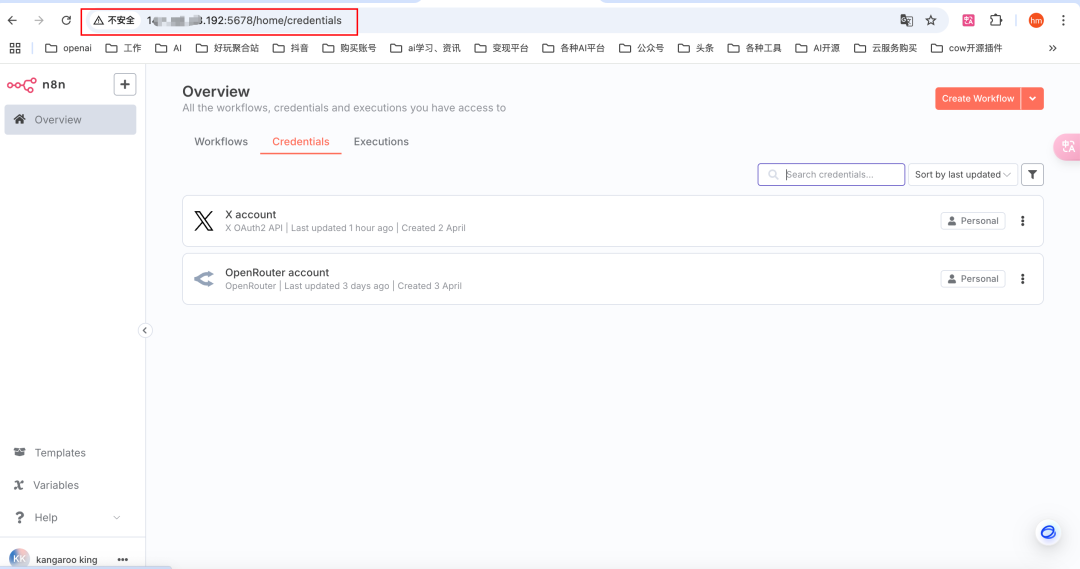

这里面有个坑,如果你想使用X等 需要配置重定向URL的节点

那么启动前需要配置N8N_HOST=外网IP,如果不指定默认是localhost,到时候X节点是无法授权成功的。

部署成功之后直接访问 http://localhost:5678,如果是部署到云服务器,请访问 http://外网IP:5678

默认是英文,可以安装沉浸式翻译一键翻译页面

附上几个实用场景

1.个人效率类:AI记账助手

2.社媒运营类:多平台一键分发

3.电商实战类:订单自动化分析

4.生活娱乐类:天气预警+穿搭推荐

5.全自动AI写稿分发;

6.热点监控:监控各家官媒,第一时间获取重要信息;

等等等...

我目前也在n8n上做了一些AI应用,但还没有优化完毕,篇幅原因,今天这篇先给大家介绍n8n,同时可以部署起来,下篇给大家分享n8n的实用案例实操~