稀疏激活的混合专家模型(MoE)通过动态路由和稀疏激活机制,极大提升了大语言模型(LLM)的学习能力,展现出显著的潜力。基于这一架构,涌现出了如 DeepSeek、Qwen 等先进的 MoE LLM。

然而,随着模型参数的迅速膨胀,如何高效部署和推理成了新的挑战。为此,学术界和工业界纷纷聚焦于模型压缩技术,尤其是面向 MoE 模型的 “专家级压缩”。研究者们通过剪枝、量化、合并等方法,剔除或简化那些 “非关键” 专家,从而在保证性能的同时,显著减小模型体积。

分析专家的重要性差异不仅有助于推动更高效的模型压缩,还为深入理解 MoE LLM 的内部行为机制提供了关键视角。然而,现有方法多依赖经验性准则来识别重要专家,缺乏对专家重要性深度的探讨。因此,本研究聚焦于一个此前被忽视的重要问题:

MoE LLM 中是否普遍存在一类在前向推理过程中发挥关键重要作用的专家子集?

通过对多个主流开源 MoE LLM(包括 DeepSeek 系列、Qwen3 系列、Mixtral 等)进行深入实证分析,来自清华大学和美团的研究人员首次发现并确认了这一特殊且至关重要的专家子集的广泛存在。尽管这些专家数量极为有限,但它们对模型性能的影响却举足轻重。

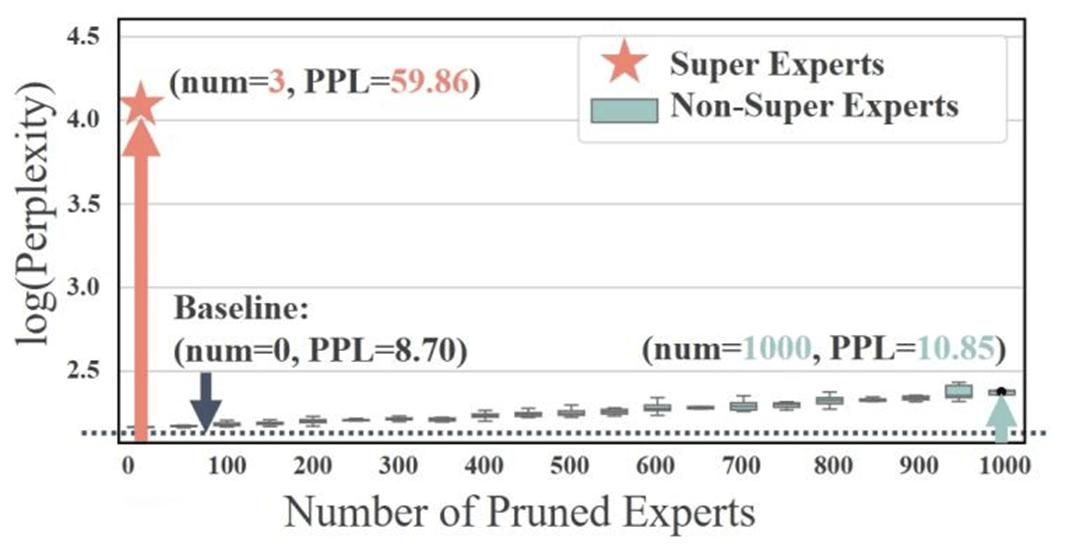

例如,在 Qwen3-30B-A3B 模型中,仅裁剪 3 个专家(从约 6000 个专家中)就足以显著降低模型性能,而随机裁剪其他专家影响较小(如 图 1 所示)。

图 1:对 Qwen3-30B-A3B 模型进行专家裁剪分析。裁剪三个超级专家将导致模型困惑度(PPL)显著退化。而随机裁剪上百个非超级专家的影响较小。

研究人员将这些专家命名为超级专家(Super Experts),并从以下三个方面进行了逐渐深入的系统分析:

1) 在不同模型和输入数据领域中的分布规律;

2) 对非推理与推理模型能力的重要性;

3) 深入分析及理解压缩超级专家对注意力机制的影响。

此外,作者还开发了一套自动化工具,能够快速且精准地识别新模型中的超级专家。

- 论文链接:https://arxiv.org/abs/2507.23279

- 开源地址:https://github.com/ZunhaiSu/Super-Experts-Profilling

超级专家:发现及定位

研究以 Qwen 最新的混合专家大语言模型 Qwen3-30B-A3B 为例,展示了发现超级专家的过程。随后,通过对不同模型和输入数据领域的分析,深入探讨了超级专家的分布特征,并进一步揭示了其在多个模型中的广泛存在。

超级专家的概念源于对密集结构大型语言模型中一个现象 —— 大值激活(Massive Activations)—— 的深入研究。大值激活指的是在大模型的解码器层之间传递的隐藏状态(hidden states)中,出现极端的激活离群点,其数值远远超出普通激活值,可能大上万倍。研究人员首先在多个开源 MoE LLM 中验证了这一现象的普遍性。

然而,研究并未止步于此,而是进一步提出了以下关键问题:

在 MoE LLM 中,这类大值激活是如何产生的?是所有激活的专家协同作用的结果,还是由少数关键专家主导?

通过对模型内部数据流的细致观察,研究得出了一个重要发现:这些大值激活现象是由极少数特定专家所诱导的。这些专家在其 down_proj 层的输出中,会产生罕见且极端的激活离群值。

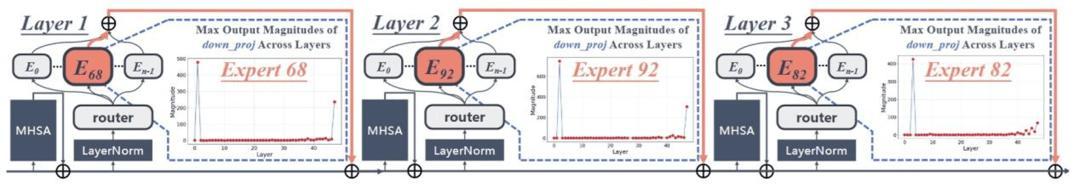

这些离群值通过残差连接累加到下一层的输入中,通过一次或多次放大,最终导致大值激活现象的出现。作者将这些诱导大值激活现象的专家称为 超级专家(Super Experts)。图 2 以 Qwen3-30B-A3B 模型为例,生动地展示了这一机制。

图 2:第 1 层的第 68 号专家、第 2 层的第 92 号专家,以及第 3 层的第 82 号专家,共同构成了一条 “激活放大链”。第 1 层的超级专家首先产生初始激活峰值,该峰值在传递至第 2 层后,被对应层的超级专家进一步放大,并持续向后层传播。最终在模型后续层中形成了稳定且大幅的激活值。

为了直接验证这一机制,作者还进行了逐层超级专家裁剪的消融实验。如 图 3 所示,当裁剪某一层的超级专家时,该层对大值激活的影响将直接消失;当裁剪所有超级专家时,原本显著的大值激活现象也随之完全消失。这无可辩驳地证明了,超级专家正是模型中大值激活的直接源头。

图 3:Qwen3-30B-A3B 超级专家裁剪消融实验。

在验证了超级专家的存在后,作者接下来讨论如何精准且自动地识别他们。基于超级专家影响大值激活产生的特性,研究提出了简洁且有效的量化定义方法。

首先统计所有专家在各层 down_proj 输出的最大激活幅值。设 L 为形成大值激活的层集,ale 表示第 l 层中专家 e 在 down_proj 输出的最大激活幅值,且 A = {ale} 为模型中所有此类值的集合。

若专家 e 在第 l 层满足以下条件,则将其分类为超级专家:

基于该定义,作者开发了一种自动化分析工具,并对多个 MoE LLM 进行了验证。结果表明,该工具效果显著(如 图 4 和 图 5 所示)。

图 4:对多个 MoE LLM 的超级专家识别,加粗的为超级专家的 down_proj 输出激活幅值。

图 5:对多个 MoE LLM 的所有专家的 down_proj 输出激活幅值热力图,其中箭头所指清晰地标注了超级专家。

基于提出的自动化校准工具,作者对多个 MoE LLM 和不同输入数据集领域进行了超级专家的定位,得出了以下关键结论:

- 超级专家普遍存在且数量稀少:在所有检查的模型中都发现了超级专家(图 5),数量占比通常远小于 0.05%。例如在 Qwen3-30B-A3B 中,6144 个专家中仅有 3 个超级专家。

- 超级专家分布稳定且不受后训练影响:研究对比了多个模型的 Base 版本与后训练版本(如 Qwen3-30B-A3B-Base 与 Qwen3-30B-A3B),发现超级专家的分布完全一致。这意味着超级专家的形成于模型预训练阶段且在后续过程持续稳定。

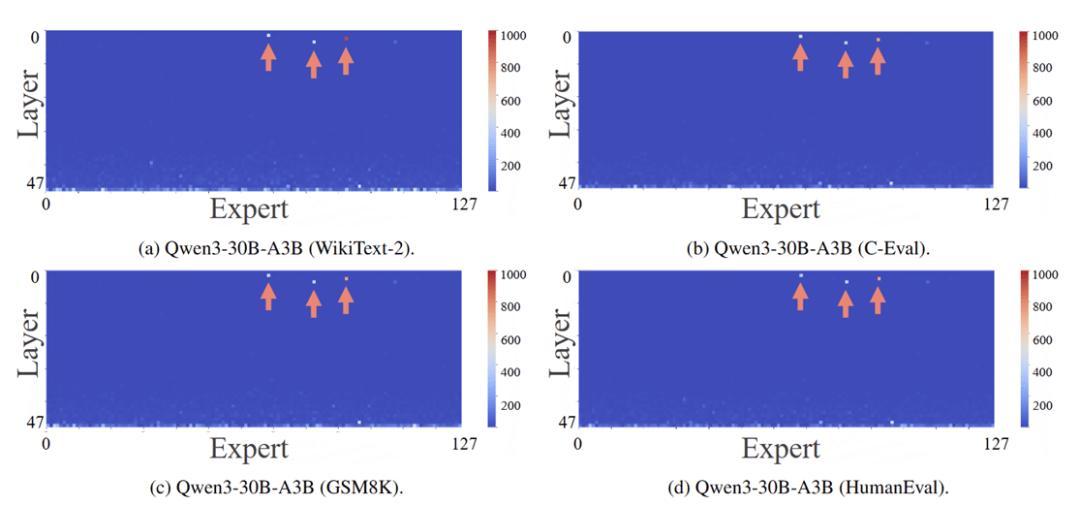

- 超级专家分布跨数据领域一致:研究还在多种不同类型的数据集(如中文文本 C-Eval、代码 HumanEval、数学 GSM8K)上进行了测试,发现超级专家的分布表现出惊人的稳定性(图 6)。

图 6:对多个输入数据集领域的超级专家分析。

超级专家重要性分析

在发现并定位超级专家之后,研究继续从非推理模型和推理模型两个维度,研究了裁剪超级专家带来的严重后果,揭示了它们的极端重要性。

对非推理模型,作者选取了 Qwen3-30B-A3B(非思考模式)、DeepSeek-V2-Lite 和 Mixtral-8x7B-v0.1 模型,在包括 ARC、BoolQ、HellaSwag、MMLU 在内的多个测试任务上进行了评估。

实验设置了三个对照组:原始模型、裁剪超级专家的模型、以及随机裁剪同等数量非超级专家的模型。

图 7:对非推理模型的超级专家重要性测试。

对非推理模型的实验结果如 图 7 所示,可以发现裁剪超级专家后:

- 性能显著下降:模型的平均准确率出现了 21.68% 到 27.21% 的下跌。

- 数学任务上接近崩溃:在 GSM8K 这类需要一定逻辑推理的任务上,性能下降尤为严重,出现了 52.71% 到 74.51% 的巨幅下跌。

- 随机裁剪影响甚微:随机裁剪同等数量的其他专家,对模型性能的影响几乎可以忽略不计。

如果说裁剪超级专家对非推理任务的影响是 “重创”,那么对需要复杂逻辑和数学推理的任务而言,其影响则是 “毁灭性” 的。

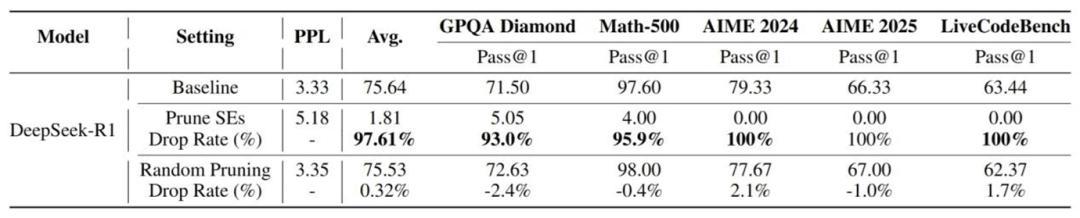

研究者选取了 DeepSeek-R1 和 Qwen3-30B-A3B(思考模式),在 GPQA-Diamond、MATH-500、AIME 等高难度推理任务上进行了测试。

对推理模型的实验结果如 图 8 和 图 9 所示,令人震惊,裁剪仅仅几个超级专家后:

- 推理能力完全丧失:在 DeepSeek-R1 和 Qwen3-30B-A3B 上一致地显示,裁剪超级专家后,对推理任务造成了重创,在 AIME 2024,AIME 2025,LiveCodeBench 等测试上,模型的 Pass@1(一次通过率)直接降为 0.00%。

- 模型思维链短路:如 图 10 所示,在对 Math-500 的测试输出进行分析时,观察到了一个非常奇特的现象。原始模型以及随机裁剪的模型能够条理清晰地分析问题,而裁剪了超级专家的模型的回答会陷入无意义的、机械的重复,直到达到最大输出长度。

图 8:对 DeepSeek-R1 的超级专家重要性测试。

图 9:对 Qwen3-30B-A3B(思考模式)的超级专家重要性测试。

图 10:DeepSeek-R1 在 Math-500 上的输出结果展示。

理解压缩超级专家

对注意力机制的影响

为什么裁剪超级专家会产生如此灾难性的后果?研究在本节进一步探究和理解其背后的深层机理,将超级专家与另一个大模型中的重要现象 —— 注意力汇聚区(attention sinks)—— 联系了起来。

在基于多头自注意力的大型语言模型中,某些特殊的 token(通常是序列的初始 token)会吸引大量的注意力分数。先前的研究表明,尽管注意力汇聚的 token 通常语义较弱,但它们的存在对于维持注意力分数的分布至关重要,许多高效模型方法例如稀疏注意力、KV cache 压缩技术都非常重视保留注意力汇聚区。

基于大值激活会引起注意力汇聚区的形成的现有研究,结合本文的研究发现超级专家会引发大值激活的现象。作者提出了以下 MoE LLM 内部机制因果链假设:

超级专家 Super Experts(根源) → 大值激活 Massive Activations(现象) → 注意力汇聚区 Attention Sinks(功能)

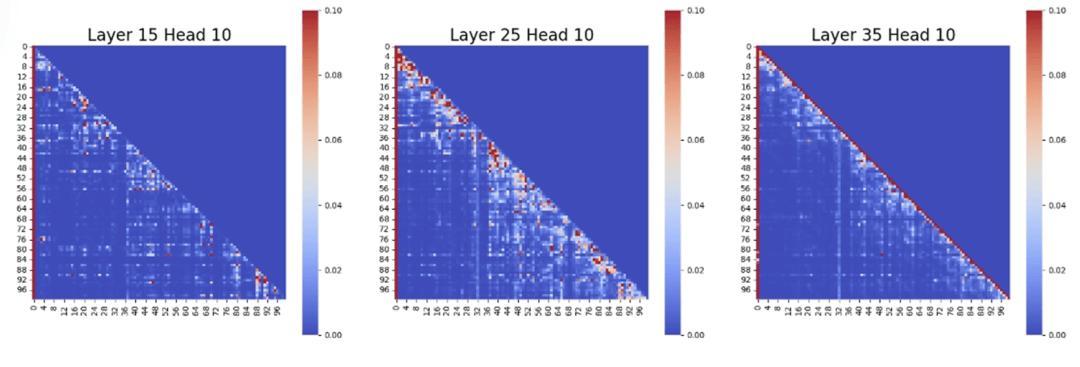

图 11:原始模型的注意力分数图,其中第一个 token 明显形成了注意力汇聚区。

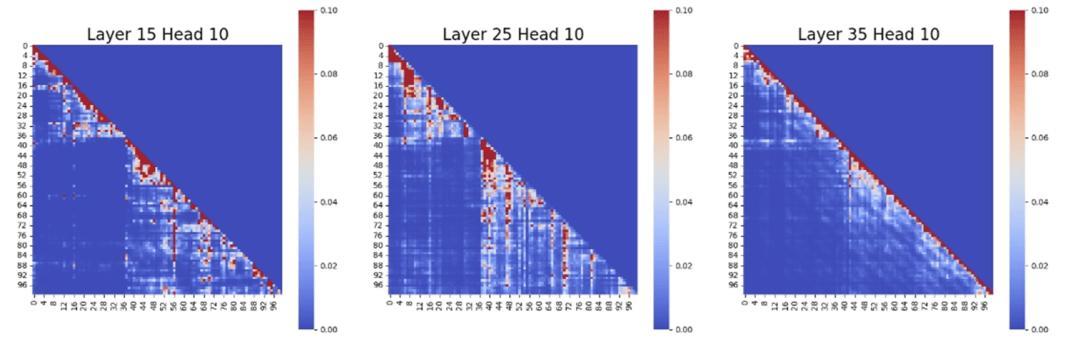

图 12:裁剪超级专家后的对应注意力头的注意力分数图,明显可以看到注意力汇聚区的缺失。

为了验证上述假设,研究设计了一个名为 “注意力汇聚区衰减率”(Attention Sink Decay Rate) 的量化指标,用于衡量裁剪超级专家对注意力机制的破坏程度。

如 图 13 所示,在裁剪超级专家后,模型所有层的注意力汇聚区衰减率都稳定在 90% 左右,甚至接近 100%。这表明超级专家的压缩,严重地破坏了模型内部至关重要的注意力机制,验证了上述提出的机制因果链。

图 11 以及 图 12 对裁剪前后注意力分数图进行的可视化分析,清晰地验证了注意力汇聚的破坏性影响。

图 13:Qwen3-30-A3B 注意力汇聚区衰减率分析。

结语

本研究揭示了广泛存在于 MoE LLM 中的超级专家机制,并通过分析超级专家的分布规律、其对模型能力的重要性以及在注意力机制中的关键作用,进行了系统性探讨。

该研究的四大核心贡献是:

1. 首次识别并系统性地分析了超级专家这一前所未见的重要机制。在多个主流 MoE LLM 中广泛验证了超级专家的存在,并揭示超级专家分布的显著稳定性。此外,本文还构建了自动化检测工具,可高效识别新模型中的超级专家。

2. 实证验证超级专家的关键作用。大量实验显示,超级专家对模型整体能力,尤其是数学推理任务至关重要。对于如 AIME、Math-500 等测试集,裁剪超级专家后模型表现近乎 “完全崩溃”,测试表现几乎降至 0。

3. 揭示压缩超级专家对注意力机制的影响。研究证实 MoE LLM 依赖超级专家形成注意力 “汇聚区”,该机制对于注意力分数的合理分布至关重要,而一旦超级专家被裁剪,该机制将遭受严重破坏,进而显著削弱模型性能。

4. 为 MoE LLM 的压缩策略提供新方向。超级专家的发现不仅扩展了对 MoE LLM 内部行为的理解,也为未来设计更加稳健的面向 MoE LLM 压缩方案提供了理论依据。

未来的研究将聚焦于探索超级专家在模型预训练过程中的形成机制,并利用超级专家开发更为高效的 MoE LLM 压缩方法。