在 InfoQ 举办的 QCon 全球软件开发大会(北京站)上,支付宝多模态应用实验室研究员李宇明做了专题演讲“EchoMimic:多模态大模型驱动下的生成式数字人技术与应用”,他围绕 EchoMimic 系列开源生成式数字人项目,介绍了生成式数字人领域最新进展、 EchoMimic 背后的技术细节、生成式数字人相关应用场景以及该领域后续研究思路与方法。

内容亮点

生成式数字人领域的技术路线,最新进展,以及与多模态大模型应用结合趋势

EchoMimic 系列生成式数字人开源项目的技术细节

生成式数字人领域后续研究方向

预告:将于 10 月 23 - 25 召开的 QCon 上海站设计了「多模态融合技术与创新应用」专题,重点讨论:如何构建统一的语义空间实现模态间深度理解、面向实时场景的多模态信息融合技术演进、大模型与企业系统的无缝集成实践、从实验室到生产环境的技术落地路径等。如果你有相关技术案例,欢迎加入这场技术共创。

以下是演讲实录(经 InfoQ 进行不改变原意的编辑整理)。

随着多模态大模型的不断发展,生成式数字人的技术融合趋势也日益明显。通过结合视觉、语音和自然语言等多种模态数据,生成式数字人可以更加完整地呈现出真实世界中的人的行为和交流方式。这种技术融合趋势将进一步推动生成式数字人在虚拟现实、增强现实、人机交互等领域的广泛应用。

EchoMimic 是支付宝多模态应用实验室发布并开源的数字人技术项目,仅需输入一张参考图像、一段音频及一段手势序列,即可生成高质量人物动画视频,同时确保半身数字人与音频内容之间的协调。EchoMimic V1 论文中稿人工智能领域顶级国际会议 AAAI 2025,EchoMimic V2 论文中稿世界国际计算机视觉与模式识别会议 CVPR 2025。

本演讲将围绕 EchoMimic 系列开源生成式数字人项目,介绍生成式数字人领域最新进展、详细讲解 EchoMimic 背后的技术细节、以及生成式数字人相关应用场景,及该领域后续研究思路与方法。

传统数字人与生成式数宇人技术背景

传统数字人技术介绍

2D 数字人技术路线

在生成式数字人出现之前,传统的数字人主要有两个发展方向。第一个方向是 2D 数字人,它是一种平面状态的数字人。在业界,2D 数字人的制作主要有两种主流方式。第一种方式本质上是“换嘴”路线。在 AIGC 出现之前,这种方式的思路较多。主要方法是通过对抗学习(GAN),先将模板视频的嘴部区域遮盖,然后利用音频驱动技术将嘴部替换上去。目前,这种模型被广泛应用。除了 GAN 方案外,之前还有一种常用的方法是利用神经辐射场(NeRF)进行建模。

这两种方式的优势比较明显。首先,它们的制作成本较低,适合快速、简单、高效的技术路线。例如,换嘴方式可以通过采购大量高清模特模板来实现。当音频输入后,通过换嘴技术使嘴型与音频匹配,这种方式速度快,算法相对简单,优化成本也较低。其次,在特定场景下,比如政务播报和新闻播报这类对表情和动作幅度要求不高的场景,这种方案的效果是可以接受的。

然而,这两种方案也存在一些不足之处。首先,优质的 2D 数字人效果依赖于模板视频,而模板视频的采购成本较高,涉及版权和录影棚拍摄等问题。其次,高质量的驱动和手势动作仍然是一个挑战。这种技术路线更适合播报类场景,但对于喜剧、唱歌或情绪表达要求较高的场景则不太适用。最后,人物的动作和嘴型生成在准确性、自然度和灵活度方面仍有不足,因为它们基于 GAN 的思路,表征能力有限。

除了前面提到的 2D 数字人之外,在 AIGC 出现之前,3D 数字人也是一种常见的数字人形式。3D 数字人在生活中较为常见,比如在政务服务平台或医院的导诊台上,可以看到这种 3D 形象。这些 3D 数字人可以进行简单的交互,例如介绍医院的导诊信息等。

3D 数字人技术路线

3D 数字人的发展主要围绕两个方向:智能建模和智能驱动。智能建模是指通过一套完整的建模和美工方式,将 3D 数字人的形象构建出来。因为 3D 数字人是动画效果,所以需要专业的建模技术。智能驱动则是让建好的模型动起来,即通过驱动技术使数字人能够进行交互。

在技术方面,随着 3DMM(3D Morphable Model)技术的普及和可微渲染技术的发展,3D 数字人的制作成本有所降低,但仍然存在一定的成本。3D 数字人的优势也比较明显。首先,与 2D 数字人相比,3D 数字人具有更强的交互能力。例如,3DMM 算法本质上是表情驱动,只要模型和参数设置得当,表情可以做得比较自然。其次,3D 数字人在形象和人设方面可以做得比 2D 逼真,符合业务场景的需求,可以生成多种角色。

然而,3D 数字人也存在明显的不足。首先,建模和驱动技术难度较大,技术链较长。从人物建模、动作设计、驱动到渲染,每个环节都需要紧密配合,任何一个环节出现问题,都会影响整体效果。其次,建模过程复杂,例如需要使用复杂的相机矩阵进行人物建模,而驱动则需要专业的动作捕捉设备和真人穿戴采集,整个过程较为繁琐。第三,建模方式难以保证数字人的质量,因为建模不仅依赖算法,还需要大量人工参与,要达到理想的效果并不容易,往往看起来不够真实。最后,3D 数字人不适合需要高写实人像生成的应用场景,因为无论建模多么精确,与真实人物相比仍有较大差距,容易让人一眼看出是假的。

生成式数字人技术介绍

近两年,随着 AIGC 技术的发展,在传统的 2D 和 3D 数字人之外,又出现了一种新的思路——生成式数字人。生成式数字人利用 AIGC 技术生成图像和视频的能力,结合多种方法,以深度学习的方式解决了传统 2D 和 3D 数字人面临的问题和挑战。

生成式数字人的优势主要体现在以下几点:

成本低:只要有足够的计算资源进行推理,就可以生成高质量的图像和视频。

克服传统数字人的劣势:其外貌和人设都是由 AI 生成的,可以根据需求生成不同角色、人物和逼真度,逼真度和表观度比传统数字人强很多。

控制方便:可以利用语音和动作对数字人进行控制,比 3D 数字人中复杂的动作捕捉控制要容易很多。

算法潜力大:AIGC 技术近年来发展迅速,其技术天花板不断提高,生成式数字人的算法天花板也随之上升,相比传统 2D 和 3D 数字人有明显优势。

不过,生成式数字人也存在一些不足:

技术较新:可参考的工作不多,开源的工作更是稀缺。

推理成本和时间高:目前的算法很难适配大规模推理,导致成本较高。

语音驱动技术尚不成熟:语音驱动是指利用音频让一张照片变成活灵活现的人物,目前这方面的可参考工作较少。

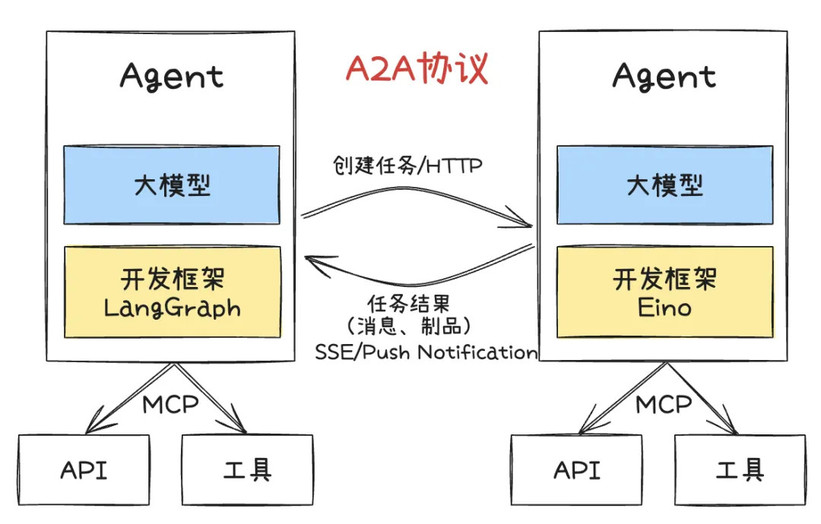

在数字人的算法解决方案方面,主要有三种控制条件:语音、文本、姿势和深度信息等。这些控制条件的目的是让数字人动起来。生成模型方面,目前主流的有 Stable Diffusion 和 DIT 架构。根据去年年底清华大学的一篇综述,目前数字人发展的主流方向有三条路线:

视觉驱动(Vision):通过一个视频驱动另一张照片进行相同的动作。例如,港科大的 Flow with Emoji、快手的 Live Portrait、腾讯的 Mimic Motion、复旦的 Stable Animator、字节的 Human DIT 和 Dream Actor 等。

文本驱动(Text):文本驱动与视觉驱动和音频驱动有重叠,目前研究相对较少,更多是作为视觉和音频的辅助条件。

音频驱动(Audio):利用音频让照片变成活灵活现的数字人。例如,阿里的 EMO、微软的 Vasa、复旦的 Hallo、EchoMimic、达摩院的 EMO 2、字节的 Omni Human 和 Meta 的 Mocha 等。

从技术演进来看,视觉驱动方向发展较为迅速,出现了多个知名的研究成果。文本驱动方向相对较少,主要是作为辅助条件。音频驱动方向则有多个知名的研究成果,其中 Omni Human 和 Mocha 可能是目前业界的天花板。

<!---->

<!---->从时间轴来看,算法的迭代速度越来越快。最初,技术迭代是以月为单位的,而现在,每周都会出现大量新的研究成果。例如,最早有 AnimateAnyone 算法,当时阿里刚发布该算法时,由于未开源,大家在 GitHub 上展开了热烈讨论,对其效果感到惊叹,一张照片竟能被驱动得如此栩栩如生,该算法在 GitHub 上的点赞数估计已有十几万。

2023 年 2 月,出现了 EMO 算法,当时大家对这一技术感到非常兴奋,认为其效果不可思议。4 月左右,Animate Anyone 和 EMO 被整合到通义 APP 中,分别命名为全民舞王和全民歌王。EMO 的效果尤其令人震惊,一张照片通过口型驱动后,几乎看不出是假的。

2024 年 6 月,腾讯开源了 MimicMotion 算法,其效果较 AnimateAnyone 有了进一步提升。由于 EMO 未开源,其技术天花板较高,因此蚂蚁团队沿着这一技术路线开发了第一版 EchoMimic V1,从效果上看已能与 EMO 基本对齐,但由于 EMO 未开源,无法进行定量评测,只能从定性角度进行比较。

2024 年 9 月,字节发布了 CyberHost 算法,效果不错。此前,Google 的 Vlogger 算法思路是用音频驱动半身或全身人物,而不仅是一个头部。7 月,蚂蚁团队已开始布局类似算法,但稍晚于字节,在 11 月发布了开源的 EchoMimic V2,对标 CyberHost。

从 2024 年 11 月到 2025 年 1 月,技术发展迅速。1 月,阿里发布了 EMO2,效果达到新高度,大表情的表证度和歌唱场景的逼真度都非常出色。2 月,字节发布了基于姿态驱动的算法 HumanDit。之后,字节推出了著名的 OmniHuman 算法,现已上线集成到创作大师中,效果非常好。4 月,Meta 发布了 Mocha 算法,字节也发布了 DreamActor-m1。整体来看,到今年这一时间点,技术进展非常迅速,与视觉生成视频大模型结合后,其能力天花板将进一步提升。

EchoMimic(基于语音驱动的人像动画生成) 背后的技术

技术细节与亮点

EchoMimic V2 版本是对 V1 版本的重要升级,从仅支持数字脸扩展到支持数字人。用户只需输入一张图片、一段音频以及一段手势,即可生成数字人。V1 版本当时对标的是 EMO,目标是利用人物头像和音频驱动人物头像动起来。然而,大家都知道,数字人的要求远不止一个头像,因此我们将 V1 版本扩展到 V2 版本,V2 可以支持半身驱动。目前,我们的开源版本在效果上已经接近市面上的一些商业解决方案,并且在驱动模态上展现了较高的灵活性。例如,V1 版本不仅可以用语音驱动,还可以用姿态驱动,也支持混合驱动;V2 版本则进一步支持手势自定义。目前,这两个版本都已经开源,V1 版本被今年的 AAAI 会议接收,V2 版本被今年的 CVPR 会议接收,感兴趣的朋友可以去阅读相关论文。

在技术架构方面,V1 版本采用了之前 AnimateAnyone 的双塔 SD 模型架构。如果大家早期就开始研究视频生成,应该对这套架构比较熟悉。它主要包含两个 unit 结构:上面的 unit 主要用于保持表观特征,例如保持人物 ID 和衣服形状等;下面的 unit 是 SD 模型的扩展版,主要负责生成视频。我们在这一基础上,增加了一些训练策略,通过 cross attention 的方式引入音频,从而达到了当前的效果。目前,该版本支持三种驱动方式:第一种是音频驱动,即只输入音频即可驱动;第二种是纯姿态驱动,这种方式类似于快手的 Live Portrait,只需输入姿态,人物就会跟随姿态动起来;第三种是混合驱动,即同时控制面部姿态和嘴部动作,嘴部动作根据音频进行驱动,我们在算法中进行了进一步扩展,实现了姿态和音频的混合驱动。

<!---->

<!---->EchoMimic V2 版本是对 V1 版本的进一步扩展。V1 版本仅支持面部动画生成,这在业务和学术价值上相对有限。因此,团队在参考了 CyberHost 等技术,并结合自身内部需求后,推出了 V2 版本。V2 版本的主架构与 V1 保持一致,但其核心创新点在于实现 V1 和 V2 数据的通用性。V1 版本积累了大量高质量的“大头”数据,这些数据包含清晰的嘴型和音频信息。然而,V2 版本需要半身数据,尤其是手部清晰、正面且无字幕的数据,这类数据在互联网上较难获取。为了解决这一问题,团队设计了特定的训练策略,将 V1 数据与 V2 数据结合进行混合训练。具体的训练策略细节可以在相关论文中查阅。

目前开源版本的 EchoMimic V2 需要预定义一个初始姿势,即用户需要先录制一段手部姿势,然后数字人可以根据这个姿势做出相应动作。由于开源版本需要人工录制或从其他视频中采集姿势序列,我们团队进一步更新了内部版本,将姿势生成自动化。具体来说,团队开发了一个“Audio to Pose”模块,该模块可以在音频驱动图像的同时,自动生成姿势。这样,无论是 3D 手部姿势还是 2D 姿势,都可以基于音频自动生成,从而实现数字人的连续推理和端到端效果。

大家在进行视频生成时会发现,即使是使用最早的双塔 SD 架构,其推理成本仍然较高。因为该架构本质上应用的是扩散模型,在实际推理时成本较高。例如,目前社区里大概有 1000 多个用户,其中很多人并非专业算法开发者,而是从事短视频生成的博主。他们手头的计算资源有限,通常只有几张 4090 显卡。为了满足这类用户的需求,我们对 EchoMimic 模型进行了进一步优化,主要优化点在于提升推理速度。我们采用了一种知识蒸馏的方法,对大模型进行优化升级。具体思路如下:目前我们的采样方法是用先进的,现有模型作为教师模型,我们在采样空间中选取若干控制点,让学生模型去逼近教师模型。以 SD 模型为例,通常推理需要 40 步,但通过这种方式,可能仅需 4 步即可完成推理,从而将速度提升 10 倍。

我们通过这种方法,对 V1 和 V2 两个版本的模型都进行了速度优化,并重新训练了学生模型,同时将学生模型公开。根据我们自己的测试以及社区用户的反馈,在 4090 显卡上,推理速度大概能提升 10 倍左右;在 A100 显卡上,测试结果显示速度提升了大约 9 倍。

<!---->

<!---->实验结果分析

下图展示 V1 版本的一些实验效果。在当时的时间节点上,像 Aniportrait、V-Express 和 Hello 等算法都是比较先进的。我们也对这些算法进行了对比。我们的社区里有很多创作者,他们对这些技术非常感兴趣。因此,在网上,包括微信、B 站或 YouTube 上搜索“EchoMimic”,会发现很多博主都在测试和使用这个算法。我们也查找了一些第三方的评测。我从一个博主网站上提取的效果图和一些定量评测结果。

<!---->

<!---->对于 V2 版本,我们也进行了评测。据我们所知,在 V2 版本之前,比我们早的工作是 CyberHost。但由于 CyberHost 没有开源,我们无法对其进行定量评测。因此,在定量评测中,我们选择了两个当时已有的视觉驱动(vision driven)或姿态驱动(pose driven)的算法。我们使用了摩尔线程的开源算法,以及腾讯开源的 MiniCmotion 进行对比。在音频驱动(Audio)方面,由于缺乏定量评测,我们从 CyberHost 的官方网站上提取了两个示例,用其图片和声音驱动我们的算法,并进行了定性对比。基本上,我们的算法能够与之相媲美。

<!---->

<!---->应用场景探索

目前我们探索到的 AIGC 数字人可以应用的几个场景。

<!---->

<!---->首先,生成式数字人结合多模态大模型是一个典型的应用场景。现在,各种 APP 中都广泛存在着对话功能,例如千问等应用中都有类似功能。之前,像豆包和千问等应用中接入了打电话功能,但目前这些功能大多是通过虚拟人物实现的,嘴型也常常对不上。如果将这些功能改为由更逼真的人物与用户交流,效果应该会比现在好很多。大家可以想象一下,未来我们使用 APP 打电话时,如果采用更逼真的交互方式,可能会更加新颖。甚至两个机器人可以自己交流起来,这可能是未来的一种趋势。

其次,生成式数字人结合 AI 创作也是一个目前比较流行的方向。通过 AIGC 技术,可以根据用户的需求生成各种数字人形象,用于内容创作、视频制作等领域,为创作者提供更多的创意和可能性。

最后,大厂通常会涉足的 AIGC 广告垂类应用也是一个重要的方向。其中一个研究热点是交互商品与数字人的绑定。例如,如果有一个商品,如何将这个真实商品与数字人绑定起来,比如让数字人戴上、穿上,或者让数字人与商品互动起来。这目前是大家研究比较火热的一个点,旨在通过数字人与商品的互动,提升广告的吸引力和用户参与度。

总结与展望

AIGC 数字人本质上是一种视频生成技术,因此它几乎会遇到视频生成领域常见的所有问题,并且由于其专注于人物这一特定领域,这些问题可能会更加突出。因为数字人直接作为展示对象出现在用户面前,所以以下几点问题尤为关键。

手部、牙齿和面部的生成质量:在所有视角中,手部、牙齿和面部的生成质量仍然是最具挑战性的。尽管面部生成相对较好,但手部和牙齿的生成问题仍然存在。手部生成尤其困难,经常会出现不符合自然规律的情况,例如多一个或少一个手指,这极大地影响了数字人的保真度。

一致性问题:这是视频生成领域常见的问题,包括人物 ID、背景 ID 和前景 ID 的一致性。动作的不协调、不符合自然规律,以及异物细节的变化,都是目前难以解决的问题。例如,数字人在视频中的动作和背景元素需要保持一致,否则会显得不自然。

动作的自然度:尤其是对于音频驱动的数字人,将输入音频的情绪与数字人的动作和表情相匹配是一个挑战。例如,当输入音频是亢奋的,数字人需要表现出相应的亢奋动作;而当输入音频是平和的,数字人则需要表现出缓和的动作。目前,让数字人的情绪与音频情绪完全一致仍然非常困难。

高清生成的难度:生成高清视频是一个常见问题,因为这需要耗费大量资源和时间。目前,快速生成高清视频仍然是业界面临的一大挑战。例如,生成一段高清的数字人视频可能需要较长的时间,这对于实时应用来说是一个很大的限制。

<!---->

<!---->针对这些困难,最近业界出现了一些新的思路和解决方案,从 2025 年年初开始,大家逐渐走上了一条新的开发思路:

SD 双塔架构

从 Animate Anyone 到 EMO,再到 EMO 2,这些早期的工作主要基于 Reference Net 框架。Reference Net 最初用于图像生成,通过双塔结构和一个名为 Tempporal Module 的模块来保证视频的连续性。这套框架在生成图像时效果较好,但在视频生成方面仍显不足,因为它本质上是一个图像框架,加上了空间平滑处理。

SVD 单塔架构

随着技术演进,业界逐渐转向使用 SVD(Singular Value Decomposition)和 DiT(Diffusion in Time)架构。虽然 DiT 架构被称为视频生成架构,但其内部结构仍不是最先进的。例如,Stable Animator 采用了这套思路,通过巧妙的方式将 ID 保持和姿态注入整合到视频生成中。

视频生成 I2V 基模+组件

从 2025 年 1 月开始,业界提出了一种新的开发范式:视频生成基模加组件的方式。例如,Omni-Human 可以定义为基模加组件的方式,通过注入特定的条件来激发模型的生成能力。这种方式已经成为目前的主流开发范式。

<!---->

<!---->基模加组件的方式有以下优势:

自带能力:基模本身具备多种能力,例如弹吉他或拿话筒说话等动作,开发者只需通过条件注入来激发这些能力。

灵活性:与早期框架相比,基模加组件的方式更加灵活,能够更好地处理复杂的动作和场景。

总体来看,虽然早期的框架如 EMO 2 已经取得了显著进展,但最新的基模加组件方式可能只是小试牛刀,就已经展现出强大的潜力。未来,随着技术的进一步发展,生成式数字人有望在更多场景中实现更自然、更高效的表现。

嘉宾介绍

李宇明,香港城市大学电子工程系博士,支付宝多模态应用实验室研究员。曾任 MINIEYE,腾讯自动驾驶实验室高级研究员。先后从事自动驾驶,量化交易,人脸攻防安全及 AIGC 等算法研发工作,在国际知名期刊会议发表论文 30 余篇,申请发明专利 20 余项,以核心成员参与完成省部级课题 3 项。

会议推荐

10 月 23 - 25 日,QCon 上海站即将召开,现在大会已开始正式报名,可以享受 8 折优惠,单张门票立省 1360 元(原价 6800 元),详情可联系票务经理 18514549229 咨询。

<!---->

<!---->