3999美元,一台迷你AI超算主机带回家!

只有老黄手掌大小的英伟达 DGX Spark正式发售!

英伟达将于10月15日星期三通过Nvidia.com和第三方零售商开始销售。

这不是一台面向普通消费者的台式机,而是面向AI开发者的迷你PC,终于准备好上市了!

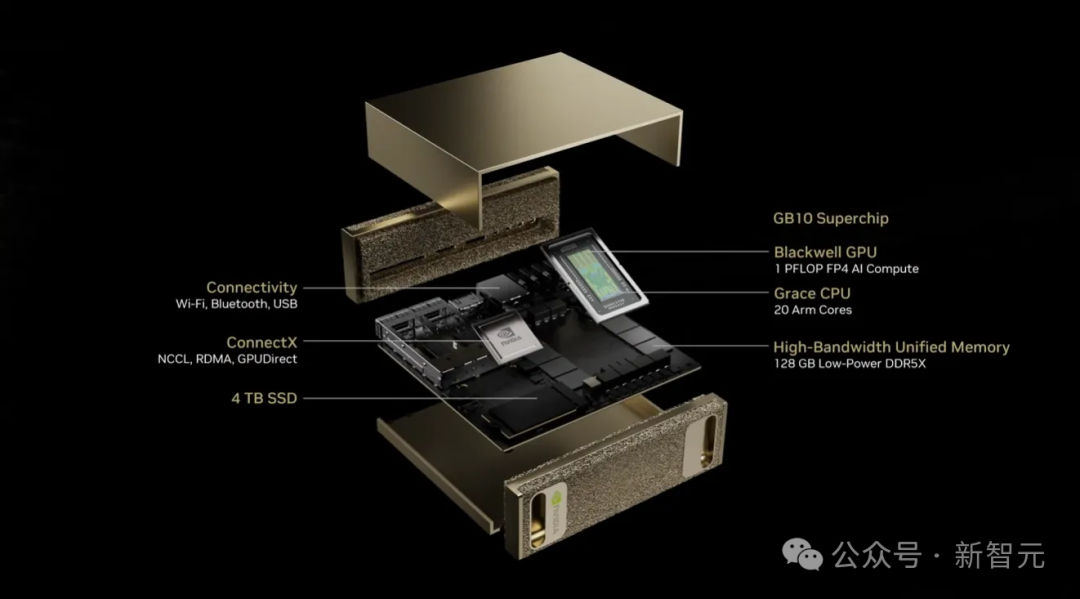

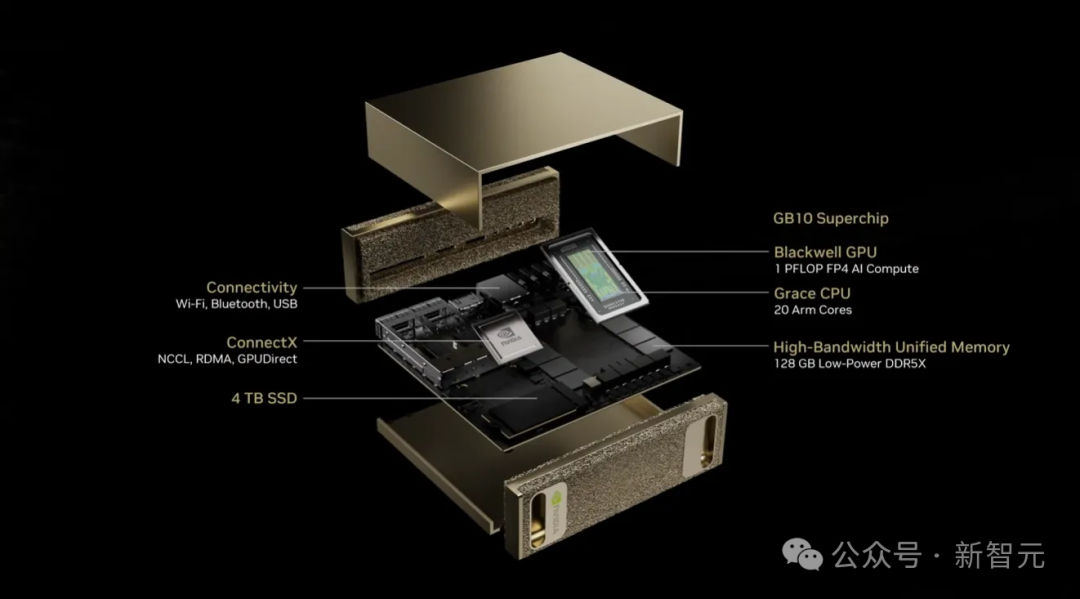

先来看下具体参数:

- 搭载英伟达GB10 Grace Blackwell超级芯片

- 这台大小和Mac mini差不多的迷你电脑重2.6磅(约1.18kg)

- 提供1 PFLOPS的FP4 AI性能

- 128GB的一致性统一系统内存

- ConnectX-7智能网卡

- 最高可达4TB存储

- 长150毫米 x 宽150毫米 x 高50.5毫米

它更像是一台用于AI训练的电脑,而非通用计算机。

DGX Spark运行的是英伟达的DGX OS,一款定制的Ubuntu Linux版本,而非Windows,已配置好AI软件。

老黄兑现GTC承诺

个人AI超算时代到来

在今年3月的英伟达GTC大会上,老黄同时发布了两款个人AI超级计算机DGX Spark和DGX Station。

Spark此前以「Digits」之名出现,是一个体积与Mac mini相当的「全球最小AI超级计算机」!

更大的Station对应机型目前尚未公布价格,主要面向「AI开发者、研究人员、数据科学家和学生,用于在桌面上对大型模型进行原型设计、微调和推理」。

为庆祝DGX Spark全球交付,黄仁勋赴德克萨斯州星舰基地,亲手将第一批DGX Spark交付给SpaceX首席工程师马斯克。

从图中还能看出,马斯克还亲笔给老黄写了一段话。

From a single spark,A world of intelligence!

To Jensen, Ad astra!

由一束火花,点燃智慧的世界!

致黄仁勋,奔向星辰!

中间的「J. H.」笔迹是老黄的亲笔签名。

其中,「ad astra」是拉丁语短语,意思是「向星辰」或「奔向群星」,常用于表达探索与追求卓越的精神。

想当年,2016年,黄仁勋向马斯克交付了第一款为AI优化的GPU。

快10年后,2025年,黄仁勋向马斯克展示了世界上最小的人工智能超算。

老黄对于马斯克才是真爱!(奥特曼不知道作何感想~)

网友们还恶搞了马斯克收到Spark后,又从盒子里拿出了MacroHard(巨硬)来送给老黄,简直太内涵了。

英伟达DGX Spark深度评测

桌面AI超级计算的新标杆

英伟达一向很少将超级计算级别的性能浓缩进桌面工作站,DGX Spark可谓一次破天荒的尝试。

它将数据中心的算力搬到了桌面,让开发者和研究人员能够在自己办公桌上握有每秒千万亿次运算的个人AI超算。

过去一年里,SGLang推理框架凭借出色性能在数据中心领域声名鹊起:该框架不仅在推理社区获得了优异跑分,还成功在大型集群上部署了诸如DeepSeek等复杂模型,利用Prefill-Decode解耦(PD)和Expert Parallelism(EP)等技术将大规模推理性能和开发者效率推向新高。

而DGX Spark的出现,为SGLang提供了一个从数据中心走向个人开发者市场的契机——将其成熟的推理框架直接带给更多开发者和研究者。

外观设计

DGX Spark 机身采用了香槟金的全金属外壳,前后面板为多孔的金属泡沫材质,质感独特且有助于散热。

这种设计让人联想到更大型的DGX A100和H100服务器。

整机造型小巧别致,如上图所示,其尺寸与一台苹果桌面主机相仿,却内蕴强大的计算能力。

来到背面,DGX Spark提供了令人惊叹的丰富接口:有一个电源按钮、四个USB-C接口(最左侧一个支持最高240W的供电)、一个HDMI视频输出、一个10GbE RJ-45千兆以太网口,以及两组QSFP网络端口(由英伟达 ConnectX-7网卡驱动,提供合计200Gb/s带宽)。

如此齐全的高速接口甚至允许两台Spark直接互联,组成一个小型双节点集群,以运行更庞大的AI模型。

值得一提的是,Spark采用USB-C接口进行供电设计,而这在台式机上可谓前所未闻。

市面上常见的高性能主机(如Mac mini或Mac Studio)通常使用传统的三孔电源线提供稳定供电,而英伟达大胆选择USB-C的原因,大概是为了将电源适配器外置,从而腾出机内宝贵空间给庞大的散热模块。

这样的设计换来了极为紧凑的机身,但代价是供电线没有卡扣固定,相对容易被意外扯掉,因此日常使用时需要格外留意避免误碰。

硬件配置

小小的DGX Spark蕴含了惊人的硬件性能。

其核心是一颗英伟达为本机定制的GB10 Grace Blackwell超级芯片,融合了10个Cortex-X925高性能核心和10个Cortex-A725高效能核心,总计20核。

这枚芯片既提供通用计算能力,又内建了强大的GPU模块。

在AI运算方面,GB10芯片的Blackwell GPU在稀疏FP4精度下可达到1PFLOPS(每秒一千万亿次浮点运算)的算力,AI推理能力大致相当于桌面版RTX 5070和5070Ti显卡之间的水平。

DGX Spark最大的亮点在于它配备了128GB的一致性统一内存,这意味着CPU和GPU共享同一片物理内存空间,能够无缝访问彼此的数据。

在这种统一架构下,Spark可以直接加载并运行超大规模的模型,而无需在系统内存和显存之间拷贝数据,大幅减少了数据搬移的开销。

我们可以一次性把上百亿参数的模型整体加载进这128GB内存中运行。

更夸张的是,Spark还具备拓展性:借助背后的双QSFP网络接口(200Gb/s 带宽),两台Spark能直连组成双机集群。

据英伟达称,双联Spark最多可以应对高达405B参数的模型(FP4精度),而这个规模已经逼近目前最大的开源大模型。

DGX Spark将数据中心级别的「大内存+高速互联+顶级GPU」组合浓缩进了不足2公斤重的一台机器里,让人不得不感叹工程奇迹。

当然,凡事有利有弊。

Spark统一内存的带宽相对有限:采用的LPDDR5x内存总带宽约为273GB/s。

对于GPU而言,这个数字远低于专业显卡独立显存的带宽(例如数据中心级H100 GPU的显存带宽接近3TB/s),因此也成为Spark在重负载 AI 推理时的主要瓶颈。

尽管如此,128GB的容量仍然给Spark带来了独一无二的优势,毕竟大多数桌面系统的显存容量远达不到这个量级,很多庞然大物般的模型在其他设备上根本「装不下」,而Spark却为此提供了可能。

性能表现

全面性能测试也已出炉。

完整评测结果:https://docs.google.com/spreadsheets/d/1SF1u0J2vJ-ou-R_Ry1JZQ0iscOZL8UKHpdVFr85tNLU/edit?pli=1&gid=0#gid=0

评测使用SGLang和Ollama两种推理框架,在Spark上跑了一系列开源的大型语言模型,并将其表现与其他设备进行了对比评估。

Spark确实能够加载并运行GPT-OSS 120B、Llama 3.1 70B这类超大模型,但这类工作负载在Spark上更适合用于原型验证和实验探索,而非追求吞吐量的生产环境。

DGX Spark真正大放异彩的是在中小规模模型的推理上,尤其当利用批处理并行时,其吞吐效率可以被压榨到极高的水平。

在GPT-OSS 20B模型的测试中(Ollama框架),Spark的预填充吞吐量约为2053 tokens/s,单token解码速度约49.7 tokens/s;

而对比之下,英伟达RTX Pro 6000(Blackwell 架构工作站卡)达到约 10108 tokens/s 的预填充和 215 tokens/s 的解码速度,约为 Spark的4倍之多。

即便是游戏级的GeForce RTX 5090显卡也跑出了8519tokens/s 和 205 tokens/s的成绩。

可见,Spark使用的LPDDR5x统一内存带宽确实在限制性能的发挥——在相同模型下,Spark的吞吐量只有顶级GPU的大约四分之一。

然而对于较小的模型,Spark能充分施展拳脚。

如运行Llama 3.1 8B 模型时,在单请求(batch=1)下Spark预填充速度约7991 tokens/s,每秒生成20.5 tokens;

当并发批处理增加到32时,吞吐量几乎线性扩展至7949 tokens/s预填充和368 tokens/s生成。

由此可见,在批量推理场景下Spark的硬件效率极高,而且多次测试结果都十分稳定,展现了优秀的并行处理能力。

充裕的统一内存也赋予了Spark一项普通消费级显卡难以企及的能力:直接运行超大参数模型。

在实验中,Spark成功加载并跑起了Llama 3.1 70B模型(FP8量化版),预填充速度约803 tokens/s,生成速度约 2.7 tokens/s。

这个绝对速度听起来不高,但想到这是一个安静地放在桌面上的「小盒子」在驱动着70B参数级别模型时,仍然令人由衷惊叹。

这种统一内存架构的妙处在此刻凸显:对研究和开发而言,能够在本地无缝加载、调试如此庞大的模型,本身就比一味追求极限算力更有意义。

评测还探索了进一步优化Spark推理性能的途径:推测式解码。

在SGLang框架中启用英伟达的EAGLE3推测解码算法后,让一个小草稿模型提前预测多个候选输出,由大型目标模型并行验证,从而减少等待时间。

在Llama 3.1 8B等模型上,启用推测解码使端到端推理吞吐量提升了最高约2倍。

这一软件层面的优化在很大程度上缓解了内存带宽瓶颈,证明通过算法创新,完全可以在Spark这样紧凑的系统上进一步榨取性能潜力。

长时间高负载运行测试中,Spark的散热与稳定性也令人印象深刻。

即使让其满负荷运行(例如并发批处理设为8,推理DeepSeek-R1 14B模型时达到2074 tokens/s预填充和83.5 tokens/s生成的高负载),DGX Spark的风扇噪音和温度依然保持稳定,没有出现任何热降频。

这得益于英伟达精心设计的金属泡沫散热结构和合理的供电散热布局。

在Spark机箱内部,由于电源适配器外置并采用了高效的散热材料,热量能够迅速排出;

相比之下,像Mac mini或Mac Studio这类小型主机在类似压力测试下往往会因为散热不足而出现性能下降。

显然,DGX Spark在持续性能输出方面展现出了专业水准的热设计能力。

典型用例

有了这样一台桌面级的AI「小钢炮」,评测也尝试了多种实际应用场景,包括模型部署服务、本地对话和离线编码助手等。

最令人舒服的是,DGX Spark预装了常用的开发环境(如Docker),降低了大模型在本地运行的门槛。

下面就结合这次体验,介绍几个Spark的典型用例。

本地模型服务与推理

DGX Spark附带的系统预装了Docker等环境,可以开箱即用地部署本地模型服务。

借助SGLang框架,只需一条命令就能启动一个开源大模型的推理服务。

例如,使用FP8量化的Llama 3.1 8B模型做测试,在Spark上运行下面的Docker命令即可启动推理服务:

docker run --gpus all \

--shm-size 32g \

-p 30000:30000 \

-v ~/.cache/huggingface:/root/.cache/huggingface \

--env "HF_TOKEN=<你的 Hugging Face Token>" \

--ipc=host \

lmsysorg/sglang:spark \

python3 -m sglang.launch_server --model-path meta-llama/Llama-3.1-8B-Instruct --quantization fp8 --host 0.0.0.0 --port 30000

几分钟内模型即可加载完毕。

DGX Spark提供了兼容OpenAI API接口的出厂配置,这意味着可以像使用云端的ChatGPT一样,通过标准的REST API与本地模型交互。

举个例子,以下简单的HTTP请求就能得到模型的回复:

curl

http://localhost:30000/v1/chat/completions

\

-H "Content-Type: application/json" \

-d "{

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "How many letters are there in the word SGLang?"}

]

}"

可以看到,通过Spark搭建本地模型服务非常简便。

从此,无论是调用开源大模型提供API服务,还是进行批量推理测试,都可以在完全离线的环境下完成,数据私有且延迟可控。

本地对话体验

当模型服务成功跑起来后,我们还可以方便地接入可视化界面,与模型进行聊天对话。

借助开源的Open WebUI前端,只需简单配置一下Spark提供的API地址,即可在浏览器中体验本地聊天的乐趣。

评测在网页上与Llama 3、Gemma 3、DeepSeek-R1等模型进行了对话,就像在用ChatGPT一样流畅。

而这里的对话完全在本地进行,没有任何云端延迟,更不必担心对话数据上传云端,真正实现了零延迟、零泄露的私有AI聊天。

离线代码助手

除了对话问答,DGX Spark还能胜任本地的编程AI助手角色。

评测尝试将Spark上运行的GPT-OSS 20B模型与现代代码编辑器Zed集成,来实现代码自动完成、内联聊天和智能重构等辅助编程功能,而且全程离线保证代码隐私。

利用Ollama工具管理本地的大模型,然后通过Zed来调用:

第一步:安装 Ollamacurl -fsSL https://ollama.com/install.sh | sh第二步:下载GPT-OSS 20B模型权重ollama pull gpt-oss:20b第三步:安装Zed编辑器(支持 AI 助手功能)curl -f https://zed.dev/install.sh | sh

安装完成后,Zed会自动检测由Ollama管理的本地GPT-OSS 20B模型,很快就在编辑器中启用了内置的AI助手。

现在,无需联网就能让AI帮我们补全代码、回答问题甚至优化重构,这种本地运行的编程助手既安全又高效。

在实际体验中,Spark驱动下的20B代码模型响应迅速,几乎感觉不出与联网的云服务有何差别。

对于开发者而言,在本地就拥有这样一位「贴身」的AI编程助手,无疑是令人欣喜的生产力提升。

英伟达DGX Spark

个人AI超算时代的开路先锋

英伟达DGX Spark带给我们的是对个人AI计算未来的美好展望。

它将曾经只属于数据中心的大内存、高带宽互连和顶级GPU性能凝练进一台精巧优雅的桌面机器。

诚然,Spark的原始算力无法与全尺寸的DGX服务器或旗舰级RTX显卡分庭抗礼,但在可及性、能效比和多功能性等方面却独具光彩。

在DGX Spark上,我们可以运行SGLang或Ollama框架来部署本地模型服务,尝试英伟达的新技术(如EAGLE3推测解码),甚至通过双机互联探索分布式推理的奥妙,而这一切让Spark证明了自己不仅仅是台袖珍超算,更是开发者的AI乐园。

DGX Spark并不企图取代云端庞然大物的地位,它的使命在于把AI实验室搬到你的桌面。

无论你是要跑开源大模型、开发推理框架,还是打造专属的私有AI助手,Spark都赋予了你在本地安静、高效完成这些工作的能力,同时保持着英伟达一贯的工程品质和优雅设计。

这台精致的小机器,称得上是个人AI超算时代的开路先锋。

参考资料:

https://www.theverge.com/news/798775/nvidia-spark-personal-ai-supercomputer

https://lmsys.org/blog/2025-10-13-nvidia-dgx-spark/

https://www.theverge.com/news/631957/nvidia-dgx-spark-station-grace-blackwell-ai-supercomputers-gtc

文章来自于微信公众号 “新智元”,作者 “新智元”