gpt-oss-120b 和 gpt-oss-20b

OpenAI终于把开源的模型放出来了。

gpt-oss系列也是自GPT2以来,OpenAI首次开源的大语言模型。

我也是美滋滋在本地用上了,20B版本通过Ollama在Apple M1 Pro 32GB电脑上运行的第一个问题,它思考了6.1s。

所以,接下来的内容我会用大白话说说

- gpt-oss的技术细节

- 如何体验上gpt-oss

- 以及gpt-oss的实际表现

Here we go!

01|gpt-oss技术细节

先说纸面数据,

gpt-oss-120b在核心推理基准测试中接近OpenAI o4-mini,只需要单张80GB GPU就可以运行。gpt-oss-20b在常见基准测试中接近o3-mini,只需要16G内存就可以运行。

gpt-oss权重在 Hugging Face 上提供下载,并且原生量化为 MXFP4 格式。而且发布前就跟Azure、Hugging Face、vLLM、Ollama、llama.cpp、LM Studio、AWS、Fireworks、Together AI、Baseten、Databricks、Vercel、Cloudflare、 OpenRouter、NVIDIA、AMD、Cerebras 和 Groq 等都提前合作好了。这几天应该都能用上。甚至微软还有Windows 的GPU优化版本。这豪华名单我只能说不愧是OpenAI。

从左到右分别是gpt-oss-120b(带工具)、gpt-oss-120b、gpt-oss-20b(带工具)、gpt-oss-20b、o3(带工具)、o4-mini(带工具)和o3-mini(带工具)

如果柱形图看起来不够显眼的话,可以看看我好朋友@洛小山整理出来的表格:

20b这个版本是很夸张的,如果纸面分数没有水份的话,也就是说目前开源的7、8、14B等这些适合在本地端侧用的模型都被gpt-oss-20b秒了。

然后,

这两款模型在工具调用(搜索和python代码执行)、少样本函数调用、思维链推理(Tau-Bench)以及 HealthBench 医疗基准测试中表现都超过了o1与GPT-4o。。。

这样的话我有点找不到订阅Plus的理由了,要不就本地gpt-oss搭配MCP,要不就上Pro保证 Deep Reserach 的用量,至于GPT Agent的话,现阶段无视就行。

除了性能外,OpenAI还罕见放出了“简化版”的技术报告,我用300个字讲解一下:

gpt-oss都采用了专家混合系统(MoE)的Transformer架构,

- gpt-oss-120b每个token激活参数是5.1B

- gpt-oss-20b每个token激活参数是3.6B

两个模型都支持128k的上下文。采用了GPT3同款的注意力模式(alternating dense and locally banded sparse attention patterns),为了提升推理和内存效率,使用了8分组的多查询注意力机制。

从训练的数据集上看,用的主要是英文纯文本,侧重点是STEM学科、编程和通用知识。负责处理数据的Tokenizer(分词器)o200k_harmony也会跟着gpt-oss一起开源,这个分词器是o4-mini、gpt-4o分词器的超集。

如果一个集合S2中的每一个元素都在集合S1中,且集合S1中可能包含S2中没有的元素,则集合S1就是S2的一个超集

gpt-oss的后训练阶段采用了o4-mini同款流程,包括监督微调(SFT)和强化学习(RL)。

跟API版本的OpenAI o系列推理模型一样,gpt-oss支持三个推理级别(低、中、高),对应不同的推理思考成本,在系统提示语(system prompt)里通过文字,一句话的形式就可以完成切换。

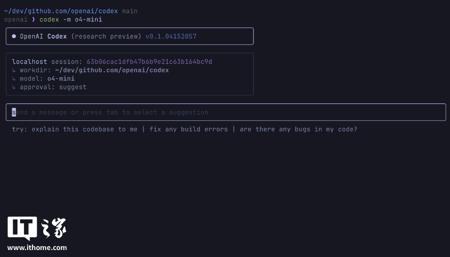

02|体验方式

目前体验这两个模型,我比较推荐两个方式,

Ollama「🔗 ollama.Com」,也就是我一开始用到的。

最近升级后有了UI页面,打开默认就是gpt-oss-20b,这时候只需要发一条消息,然后等待模型下载完成就可以了

如果没有大于16GB内存的硬件条件的话,可以去试试隔壁的OpenRouter「🔗 openrouter.ai」,

它甚至把Claude Opus 4.1也上线了,

就价格来看的话,只有OpenAI o3的7%,甚至比我们的价格王DeepSeekR1便宜。不过参数大小摆在这,我们还是要看看真实性能。

03|真实性能

后续我再想想怎么接入Claude Code或者把拉垮的CodeX配置起来,测试一下gpt-oss项目级的编程能力。今天的话就先跳过简单题,测试一下编程、学科和推理的大题。

简单的3D模拟拉不出两个模型的差距:

我上来直接零帧起手,管你是不是gpt-oss,先做一个完整的3D模拟、完整的2D游戏、 天气组件看看「其实就是稍微复杂点的3D gpt oss都写不出来。。。」。

gpt-oss-120b(思考5s,一言难尽):

gpt-oss-20b(思考9s,一言难尽):

就我目前测下来,gpt-oss的编程能力没想象中出色,隔壁Claude4.1估计可以先半场开香槟了。

后面这两道大题,是我的好朋友 @赛博小熊猫Loki 提供的。

先来看看数学,

A与B好奇问C的年龄,爱卖关子的C给出了以下11个数字,C的年龄就是其中的一个:35、36、38、42、45、46、51、55、57、61、62,

并且分别把年龄的十位数告诉给A,把个位数告诉给B

此时,A和B发生以下对话:

A:我不知道C的年龄,我知道你不知道。

B:原本我不知道的,现在我知道了。

A:现在我也知道了。

那么,请问C的年龄是?

gpt-oss-120b(思考4s):

gpt-oss-20b(思考6s):

好在数学题没拉垮,思路还是很明确的。

接着是七个小矮人的推理题,

七个小矮人的秘密

七个小矮人在遇到白雪公主前,他们来自不同家乡:水晶洞、松果林、蘑菇谷、彩虹桥、月光湖、岩石山、向日葵田;从事不同职业:矿工、园丁、厨师、医生、歌手、木匠、渔夫;喝不同饮料:薄荷茶、苹果酒、蜂蜜水、热可可、柠檬汁、姜茶、草莓奶昔;戴不同颜色帽子:红、黄、蓝、绿、紫、白、黑;使用不同交通工具:独轮车、滑板、雪橇、三轮车、马车、小船、自行车。有一天,他们的交通工具从左到右排成一行,请根据以下条件推理:1、Doc戴红色帽子

2、Grumpy的交通工具是雪橇

3、Happy来自向日葵田,职业是歌手

- d.矿工喝热可可

5、三轮车紧邻小船左侧

6、月光湖居民戴紫色帽子

7、医生的交通工具在正中间

8、Sneezy 住在彩虹桥,戴黄色帽子

9、Sleepy的交通工具在滑板右侧第三位

- j.喝苹果酒者的交通工具与渔夫相邻

11、Dopey 的帽子颜色比 Bashful深(黑>紫>蓝>绿>黄>红>白)

12、园丁使用独轮车

13、岩石山居民戴黑色帽子,交通工具在马车左边第二位

14、喝柠檬汁者的交通工具与医生相隔一辆

15、蘑菇谷居民喝姜茶

16、厨师的交通工具紧邻戴蓝色帽子者

17、使用小船的人来自松果林

18、Happy 不戴白帽子

请问谁戴黑帽子?

gpt-oss-120b(思考61秒,但没答对):

gpt-oss-20b(思考83秒,再起不能):

遇到这种复杂推理题,20b会开始出现重复生成的情况,直到卡住不动。

写在最后

我们等这一天都等太久了,

蹲草莓、蹲Orin、蹲发布会

OpenAI终于当了一回字面意义上的OpenAI了。

这周大概率还会有GPT5,

这款从24年期待到25年,

一度被称为AGI起点的模型

真的,我现在已经睡不着了,

也顾不上时差不时差的了,

我要一口气测24小时!

别鸽我了,

我不差Token,

真的。

文章来自于微信公众号“卡尔的AI沃茨”,作者是“AI沃茨”。