全网开扒GPT-oss,惊喜发现……

奥特曼还是谦虚了,这性能岂止是o4-mini的水平,直接SOTA击穿一众开源模型。

不仅轻松通过多项性能测试,网友也整起了各种花活:

论文解读、整理数据,甚至造出类似于Grok 4 Heavy的GPT-oss Pro版。

背后架构也是被大佬们挖掘得明明白白,只能说开源真妙哇!

终于理解奥特曼提前预告的那句话是啥意思了:

即将进入SaaS的快时尚时代。

估计接下来OpenAI还有不少好东西要陆续发布……

全网开测GPT-oss

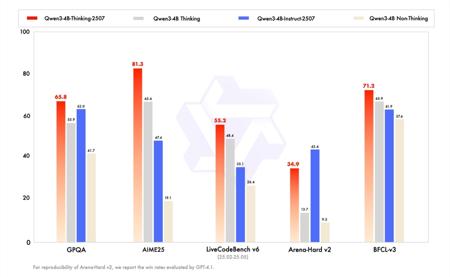

首先,全网最关注的基准测试新鲜出炉,GPT-oss直接登顶开源模型王座。

横扫GPQA Diamond、AIME 2024、AIME 2025和Codeforces榜单,超越DeepSeek R1、Qwen3、Llama 4、Kimi K2等一众开源模型。

不过在MMLU上确实还是Qwen3-235B更胜一筹,Kimi-K2也在SWE-Bench上得分更高。

在核心推理基准测试中,GPT-oss实现了与o4-mini等同的效果,可以在单个80GB的GPU上高效运行。

另外在一些常见基准测试中,性能也比肩o3-mini,且只需要一个16GB内存的边缘设备,预计GPT-oss将会成为本地推理或快速迭代的理想选择,而无需昂贵的基础设施。

最小的20B模型可以轻松通过以下三项编码测试,比一些规模远超过它2-3倍的模型效果要好得多:

- 模拟球在旋转六边形内弹跳,GPT-oss以较高的准确性尽可能还原了真实物理情况。

- 直接增加到20个球,放入七边形弹跳,且在每次弹跳都提高速度,GPT-oss同样顺利完成。

- 让GPT-oss制作一个具有光照、阴影、反射的球体3D渲染场景,结果依旧完美契合指令。

然后是每个大模型都逃不过的经典问题:英文草莓里有多少个字母“r”?

GPT-oss 通过

让GPT-oss两个型号均参与鹈鹕推理测试,模型准确勾勒出了车架轮廓和鹈鹕躯体,比例上也相对均衡,充分体现模型具备足够的空间想象力和逻辑连贯性。

除了测试以外,网友们也开始探索GPT-oss的更多使用途径,例如alphaXiv迅速将模型配置到官网,率先用于论文理解。

用户可以对论文的任何部分进行手动选择并针对性提问,还能@关联其它论文,快速获取背景信息并进行比较。

只需要简单的一行代码,就可以利用GPT-oss将混乱的原始数据(如PDF、Word、XLSX)转换为一个强大的LLM测试集。

更有甚者,直接推出了GPT-oss Pro版,类似于Grok 4 Heavy,将10个GPT-oss连接在一起,可以生成比单个模型更优质的结果。

不过这些都只是前菜,官方技术文档里说不明白的架构,网友们也是直接扒了出来。

扒一扒技术架构

与类似大小的Qwen3相比,前威斯康星大学麦迪逊分校统计学教授、RAIR Lab创始人Sebastian Raschka发现,GPT-oss在结构上更宽,拥有更多的注意力头以及前馈层中更高的隐藏维度,更深的层次则是源于更多的Transformer模块。

另外有意思的是,他还发现GPT-oss在注意力机制中添加了偏差单元,这一结构上一次出现还是在OpenAI六年前开源的GPT-2。

GPT-oss在架构设计上既保留了MoE Transformer的核心架构,又通过细节优化提升性能、降低复杂度,使其成为适合开源模型的基础架构,Dimitri von Rütte和MIT研究员Adam Zweiger扒出其所涉及的技巧包括:

- 对每个注意力头,设置一个可以学习的标量,然后进行softmax汇聚。

- 与GPT-3相同,交替使用滑动窗口层和全连接层。

- 对每个输入分配4个相关专家处理,再整合结果,专家之间彼此完全独立,同时使用标准负载均衡损失,确保资源高效分配。

- 使用了改进的swiglu激活函数,通过α=1.702让sigmoid的线性单元silu近似于高斯误差线性单元gelu。裁剪激活值防止梯度爆炸,通过调整“up+1”有助于梯度流动。

- 采用YaRN上下文窗口扩展技术,提升长文本处理能力。

- 移除了RMSNorm归一化过程中的可学习偏置参数,减少拟合风险。

- 去除了对query(Q)和key(K)的归一化,以及注意力软帽(attention softcap)。

另外有网友henry还发现GPT-oss-20B的思维链,有时候也会进行很多重复的思考,也许存在一个重启机制,会检查类似情况并重新生成输出。

至于模型成本,根据官方说法,GPT-oss-120B花费了210万H100小时,而20B是它的十分之一。

程序员Simon Willison根据英伟达H100的定价计算,即每小时在2美元到11美元,意味着120B参数的模型成本在420万美元到2310万美元左右,20B则是42万美元到230万美元之间。

不过ellamind创始人在测试中发现了GPT-oss的一些bug,例如在非英语文本上表现不佳,模型响应在超过55%的情况下都包括语法或拼写错误,推测模型只使用了英语进行训练。

官方也是立即发布了相关技术文档,介绍如何对GPT-oss进行微调,使其可以对多种语言进行有效推理。

简单来说,就是安装必要的PyTorch库,下载并格式化Multilingual-Thinking数据集,并在数据集的基础上对模型进行LoRA微调,以生成英语、西班牙语、法语、意大利语或德语的多语言思维链。

OMT

那么想必很多朋友想要立马上手GPT-oss了吧,尤其是能直接在手机上运行的20B。

这里提供一个相对简单的获取方法,直接先下载一个LM Studio(适用于Windows、macOS和Linux),再在搜索栏里输入“GPT-oss-20B”下载即可。

另外,AWS今天也宣布将通过Amazon Bedrock和Amazon SageMaker AI平台正式上线该OpenAI开源模型,直接能够快速便捷地构建生产式AI应用。

除了民间网友的实测,一些专业大佬们也加入了这场开源风暴。

吴恩达测试GPT-oss-120B后,认为其性能相当强大:

Qwen著名研究员Binyuan Hui也表示如果GPT-oss完全使用的是合成数据训练,那么该方法将有助于小模型实现更好的性能。

也欢迎屏幕前的你动手体验GPT-oss,并在评论区留下你的实测结果。

参考链接:

[1]https://x.com/rasbt/status/1952842273848279364

[2]https://cookbook.openai.com/articles/gpt-oss/fine-tune-transfomers

[3]https://x.com/mattshumer_/status/1952791480210162060

[4]https://x.com/RafaCrackYT/status/19528380874420882

[5]https://x.com/hud_evals/status/1952846781286658393

[6]https://simonwillison.net/2025/Aug/5/gpt-oss/

[7]https://x.com/AdamZweiger/status/1952799642636148917

[8]https://x.com/arithmoquine

文章来自于微信公众号“量子位”,作者是“鹭羽”。