Sheet0.com: the first Level 4 Data Agent

在过去两年里,AI Agent 从早期的技术探索逐渐进入应用落地期。无论是 OpenAI、Anthropic 等头部公司推动的通用型 Agent,还是垂直场景下的自动化工具,市场都在快速验证一个趋势——数据已成为驱动 Agent 能力的核心燃料。然而,获取、清洗、组织高质量数据的难度和成本,依然是阻碍 Agent 大规模应用的关键瓶颈。传统的数据采集方式要么依赖工程团队开发程序,要么依赖低效的人工操作,这在信息碎片化和实时化的今天,已无法满足市场对准确性和速度的双重要求。

在这样的背景下,Sheet0 选择从一个被长期忽视、却极具爆发潜力的赛道切入——为人类与 Agent 提供“L4级别实时数据收集与交付能力”。不同于依赖单一工具调用的方案,Sheet0 底层通过将用户数据需求翻译为可执行代码,建立了可解释、可回溯的动态 Workflow 系统,加上 Data Environment 驱动的反馈闭环,当执行报错时,Sheet0可以进行自我修复。在内部测试中,Sheet0 在两分钟内准确收集 YC 官网 294 家公司的全量信息,并且可以根据用户进一步需求,收集创始人教育、工作经历等数据。成本和速度均比其它Agent产品低一个数量级。

创始人王文锋作为连续创业者,在AI、基础软件与大规模分布式数据处理领域的近十年工作经验,让他在数据工程、上下文构建(Context Engineering)以及可组合系统架构上具备深厚功底。这不仅让 Sheet0 能在技术实现上跑得更快、更稳,也让他在市场节奏与产品定位上有着极为稀缺的超前判断力。

Sheet0不只是想做一个数据收集工具,而是一个为超级个体、知识工作者以及 Agent 网络提供实时数据的高效聚合层,旨在打造专属于Agent的Google.com。在 AI 应用的下一阶段,谁能解决数据从收集到结构化交付的全链路问题,谁就有机会成为 Agent 互联网的关键枢纽。Sheet0 正在用它的技术体系与市场切口,快速逼近这个位置。让我们一起走进Sheet0和它的创始人王文锋的故事,lets enjoy!

- Chat就是新时代的前端......制约这个“新前端”能力的,是模型对实时数据的获取能力...谁可以对模型提供实时数据的供给能力,谁就是Agent时代的“新后端”

- Sheet0的产品定位为 L4 级 Data Agent......在我们的场景中,这个目标就是 “实时获取并交付结构化数据”。用户只需提出需求,我们就能将数据收集、整理成可直接用于分析或可视化的表格,这就是我们对“L4 级 Data Agent” 的定义。

- 与市面上的其它产品相比,我们最大的差异化是如何“又准又快”为用户交付“100%准确,0幻觉”的结果。实现这一点的关键,是将任务拆解成可解释、可校验、可回溯的底层 workflow代码,让数据收集与处理过程透明、结果可靠。

- 如果把Agent当“人”来看的话,或许把Sheet0.com当做属于Agent的Google.com更合适(笑)。

- 人类存在的本身是不是就是AGI存在的最好证明?因为人是大自然在复杂物理规律作用下的产物......智慧本身是物理规律作用的结果。有一个词叫“心理障碍击碎效应”......大自然已经给我们打了样,证明智慧的存在是物理规律,所以我们有什么理由去怀疑模型不持续进步呢?

- AI发展很快,大家都很FOMO,很多时候大家都是被推着走。我一直在提醒自己:当一个东西开始泛滥的时候,一定要从浪花里跳到岸上,想想什么是稀缺的?

01 从程序员到技术创业

Z Potentials:首先恭喜Sheet0完成了500万美元融资,我好奇团队真的只有两个人吗?

王文锋:谢谢,签TS的时候,加上我确实只有两个全职的同事和一个实习生。现在要比当时多一些。

Z Potentials:能否请您分享一下过往的工作和创业经历?特别是您毕业后在人工智能和基础软件领域的探索,这些经验如何塑造了您对当前创业项目的认知?

王文锋:我的职业经历可以分为两个大阶段。我是2017年毕业,前4年在写代码,后4年在创业。2019年我加入了地平线,负责地平线AI平台下面的数据平台,主要是数据存储和清洗。2021年的时候,基础软件投资很火,因为我的老本行是做消息队列的,也是基础软件的一种,所以就跟着朋友一起去创业了,成为了联创和CTO。2023年夏天的时候,决定做Agent,就投入了LLM创业的大潮。

在地平线有一帮天才的算法工程师和科学家,我在他们的熏陶下,逐渐认识到“高质量数据会才会产生更好的智能”。而长期的基础软件开发和设计经历,培养了我的技术品味和产品直觉,这对我思考做产品产生了非常重要的影响。

Z Potentials:您头六年都在和数据打交道,那您如何看待数据在如今Agent与人交互中的重要性?再谈谈Agent时代数据的特殊价值?

王文锋:首先要区分数据的类型和应用场景——面向人的数据与面向Agent的数据是完全不同的。

对于Agent,数据的价值主要体现在三个层面:

第一,模型训练。高质量数据是模型智能的根基。业内关于GPT-5效果不及预期的讨论,本质就是高质量训练数据接近枯竭。在地平线做自动驾驶时我们也发现,比起调参,补充一批高质量数据对特定case的提升更显著。优质数据必须明确输入、输出以及中间过程数据,这些才是模型真正学习的核心。强化学习同样依赖这种任务步骤数据与奖励信号。

第二,运行过程。在运行时,核心数据是上下文(Context),应包含任务执行的所有步骤数据,并经过结构化管理、语义化处理与因果关系定义。Claude Code近期的表现,就得益于对工具调用消息的精细语义化区分。对Agent而言,好的数据就是组织良好的语义化Context。

第三,工具调用。本质上在获取第三方实时数据来补充自己上下文。今天模型的Tool use,或者MCP,基本都是封装了一个代码函数,然后通过代码访问背后的数据。但如果我们认真的去思考,这个代码函数必要性有多大?因为代码的本质是在操作底层的结构化数据。所以模型为什么不能直接用SQL来获取数据而是非要走经过一个代码的中间层?

对人类用户,数据的价值,除了业务价值外,更多在于可验证性与心理安全感。用户需要确认结果来源,以网页数据为例,数据是怎么从网页上取下来的,取下来之后又经过哪些处理环节,我们可不可以以一个简单直接、端到端“白盒”的方式呈现给用户?准确和可解释我相信会是数据最稀缺的一个品质,一定要让用户敢用。

02 Sheet0, the first Level 4 Data Agent

ZP:请介绍一下,我们的Sheet0平台本质上是什么,有哪些功能?

王文锋:好的。我想先从短期目标和长期愿景两个层面来介绍。我们把Sheet0的产品定位为 L4 级 Data Agent。

“L4”这个说法最常见是在自动驾驶领域——L4 意味着你只需告诉车从 A 地到 B 地,剩下的过程它全程接管。同样逻辑放到 Agent,就是用户只需描述目标,系统便能自主完成任务并交付结果。

在我们的场景中,这个目标就是“实时获取并交付结构化数据”。用户只需提出需求,我们就能将数据收集、整理成可直接用于分析或可视化的表格,这就是我们对“L4 级 Data Agent” 的定义。

短期来看,我们的核心能力是将任意数据源(网页、文件、API)转化为结构化的 Data Sheet。举个真实案例:某客户想分析 Twitter 上哪些 KOL 的“爆款率”更高。原因很简单——Twitter 是重要的舆论与营销渠道,做投放时自然希望选择爆款率高的博主,以获得更到的ROI。客户只需告诉Sheet0这个目标,它就会自动收集相关博主的历史推文及浏览量、回复数、转发数等数据,整理成结构化表格,并通过 SQL 计算每位博主的爆款率,最终交付完整结果。

与市面上的同类产品相比,我们最大的差异化是如何“又准又快”为用户交付“100%准确,0幻觉”的结果。实现这一点的关键,是将任务拆解成可解释、可校验、可回溯的底层 workflow代码,让数据收集与处理过程透明、结果可靠。

长期来看,Sheet0将为超级个体、知识工作者以及 Agent以自然语言的方式提供线性可扩展的实时数据获取和处理能力。

Z Potentials:怎么理解?你认为未来数据对 Agent 的重要性是什么?

王文锋:在软件里面,后端本质上为前端提供实时可渲染的数据。这些数据随机的分布在不同的数据库、文件系统、或者某个 API 里,所以需要后端工程师手动去聚合他们。

我现在经常会思考,或者说质疑一些可能被大家认为是常识的东西。比如说:用户一定需要一个普遍意义上的前端吗?我的看法是Chat就是新时代的前端,一次性App是出现在对话框内的生成式UI组件。我认为从GTP5开始,我们会很快看到这个趋势。

现在制约这个“新前端”能力的,是模型对实时数据的获取能力,因为“新后端”还没有出现。谁可以对模型提供实时数据的供给能力,谁就是Agent时代的“新后端”。从这个角度出发,Sheet0也许有机会成为这个“新后端”。

为什么实时数据这么关键?对Agent而言,数据可以分为知识和信息,模型为Agent提供了足够的知识,但非常缺信息让模型实时决策。Context Engineering的本质是在为Agent组织这些信息,一方面是记忆,一方面就是实时数据。然而Agent获取实时数据的方式还非常原始和不智能,需要一个更标准的方式让模型可以获取实时数据。

这也意味着,未来的竞争重点不一定是“我有多少数据”,而是“我能多快、多精准地为Agent 提供实时数据”。一旦数据获取速度接近实时、交易成本趋近于零,Agent 之间的协作效率就会产生质变。你可以想象,某个 Agent 在执行任务时,瞬间调用来自不同节点的多组数据,就像今天的 API 调用一样自然,这种模式会极大压缩信息不对称和Agent的能力边界。

所以,我们关注的不是成为唯一的“数据源”,而是成为 Agent 生态中的高效数据聚合层,以更标准的方式为Agent提供实时数据访问能力。如果把Agent当“人”来看的话,或许把Sheet0.com当做属于Agent的Google.com更合适(笑)。

Z Potentials:你们怎么做到数据"100%准确,0幻觉"的?

王文锋:现在很多Agent产品,都侧重于端到端的替用户完成任务,强调自主性;而我们采用的是“多次确认,逐步对齐”的策略,强调准确性。所以我们的“100%准确,0幻觉”只针对Sheet0成功完成任务,交付给用户的数据。因为如果任务失败,用户会得到一张空表,我们不存在中间的不确定性。

在具体的产品实现过程中,我们主要依赖两点:

1.动态生成且可迭代优化的执行流程:我们不是写死一套抓取逻辑,而是让 Agent 在任务执行过程中,如果遇到一些例外情况,会重写、优化 Workflow 和代码。这意味着同一个任务,多次运行间可能底层逻辑完全不同,但用户无感知,因为用户看到就是一张数据表。

2.数据环境(Data Environment)驱动的反馈机制:Data Environment是Sheet0的RL环境,承载了运行监控、错误分类、上下文过滤、数据验证等功能。这让 Agent 在每次失败后,都能基于明确的、结构化的反馈来做调整,而不是依赖模糊的语言描述去“猜”问题出在哪。

所以从技术角度出发,Sheet0本质是一个非常精通处理数据问题的Coding Agent——先写代码,跑测试,收集报错,再迭代改进,直到可稳定长时间运行为止。

ZP:我们现在已经有了初步的内部内测用户,能不能请你分享一下用户场景?有没有对这些用户进行过画像分类?尤其是有没有一些出乎意料的“长尾场景”,让用户觉得效果特别好,甚至解决了他们很大的问题?

王文锋:我们现在的主要场景还是集中在公开互联网数据的收集上面。

第一个案例来自国外的外包平台,比如 Fiverr 这类自由职业网站,“数据收集”一直是一个很大的服务类别。一位美国用户发布了一个预算 20 美元的任务——抓取台湾某线上活动分享网站的活动信息。这个网站设计非常老旧,大约是 20 年前的样式,活动数据不是表格,而是散落在地图上的一个个标记点中。用户的目标是从 700 多个活动里筛选出适合 2-4 岁小朋友的活动,并整理出来。

传统方式下,这需要逐个点击地图标记,弹出窗口,再手动复制粘贴,非常耗时;由于涉及地图交互,要让程序员写脚本成本高、周期长,而且未必有人愿意接这种低预算任务。而我们的工具恰好解决了这个痛点。

第二个案例是一个销售线索生成的典型需求。一位用户在寻找 AI 潜在客户,他们的工作流分两条路径:

- 第一条:收集市面上的 AI 公司信息。他们会先从 AI 工具类网站抓取公司列表,再聚合整理,并为每家公司寻找合适的联系人和邮箱,这些信息分散在公司官网和公开渠道。

- 第二条:基于已有的大量客户邮箱,分析哪些客户公司正在进行 AI 转型。他们会将邮箱映射到具体公司,研究业务领域,判断是否与 AI 相关,并打上标签。

如果用传统软件开发方式,搭建这样一条端到端的数据处理流水线,需要程序员数周的时间。而这位用户借助Sheet0,直接串联数据采集、清洗、匹配和标注的全流程,快速生成了可用的线索名单。

我们在 waiting list 阶段几乎没有做任何宣传,纯靠自然扩散,就积累了3000名waitlist用户。我们会在8月12日开放早期版本测试,感兴趣的朋友可以添加Hxrbusha获取邀请码(如果被限制可以在文锋公众号留言:bet-on-agi)。

因为实现终极目标还很远,路径很关键。所以结合产品方向和实际用户需求,我们初期选择公开互联网的数据抓取场景,先成为最强的AI数据收集工具,可以让每个公开网站变成结构化数据表。并会先深入支持产品经理、市场运营等人员数据方面的需求。

ZP:在商业模式上,你们是如何规划的?尤其是在 AI 接单、为人类完成任务这个方向上,未来希望构建一个怎样的社区?

王文锋:短期来看,我们采用与多数 Agent产品类似的 Credit(积分)计费模式,基于底层实际的资源消耗量来计算。

从长期看,我们会探索结果付费的可行路径。比如,当用户需要的数据在公开渠道或我们现有数据库中都找不到时,可以由用户自行设定愿意支付的价格,生成任务并分发到Sheet0平台用户网络中。如果其他用户恰好拥有这些数据并愿意出售,就能直接达成交易。这种模式的关键在于——定价权交给用户,Sheet0知道谁有数据,负责撮合,让数据在用户间实现高效、可控的流通。

03 从方向试错到坚持长期主义

Z Potentials:你在 2023 年创业后,也经历过一些方向转型,在行业判断或者技术路线选择上,有没有走过的弯路?又从中得到了哪些收获呢?

王文锋:总的来讲,就是心太急,预期没管理好。

我正式开始创业是在 2023 年 7 月,第一个方向做的是 AI Coding,公司名直接就叫 LLM Programming,意思就是“大模型编程”。当时的切入点比 Cursor 更激进——先让用户写好产品需求文档(PRD),然后直接转化成用户可以使用的软件,其实就是今天的Vibe Coding。大家可能知道,Cursor 在 2024 年 5 月之前的新模型出来前表现其实一般,直到 Claude 3.5 出来后才一下子起飞。我们当时对模型的理解和信任度还不够,加上推进得过急,最终效果不理想,所以决定换方向。回头看,这次常识让我开始相信模型的能力会持续进步。

第二个方向是 Tool Use,叫NPi,全称叫Natural Programming Interface,自然语言编程接口。上过HackerNews前十和 Madrona Ventures发布的全球第一份Agent Infra榜单。NPi在2024 年 2 月启动,到 6 月就有了比较完善的第一版。之所以选择Tool use是第一个方向的尝试让我们坚信Agent需要Take action。事实上,现在回头看NPi,会发现那时我们做的正是后来的MCP,提前了半年,不仅定义了流程和规范,还做了完整实现。和我们同期做一样事情的公司叫Composio,印度团队,今年上半年完成了光速美国领投的2900万美元的融资,现在是硅谷的当红炸子鸡。

NPi第一版做完后,我总共聊了30+ Agent开发者,发现大家关注的重点都不是Tool use(事实上MCP火也是25年2月Cursor支持了MCP后),都在搞RAG。核心原因是当时大家的问题不是没有合适的Tool,因为用LangChain之类的框架做个Tool很快,痛点是如何让Agent选对Tool。在这个过程中,我意识到Agent的关键是Context,所以总结出来了Context Engineering。而纯做Tool layer又接触不到Agent的Context,无法提高工具调用精度。这让我意识到,单纯做 Tool Use 产品是不够的,于是我们决定往上层走,经过很长时间的探索,最终做了Sheet0。

从第一个到第三个项目,其实底层初心未变:让普通人也能用极简的方式获得工程师的“超能力”,即把复杂的问题简单化后自动化的能力,也是pivot过程中始终会思考的问题。一开始想的是让AI能帮人写程序,之后觉得代码对普通人不友好,所以开始做Tool use,因为程序员做的事情是在串联不同的代码工具接口,如果模型可以做好Tool use是不是可以看不到代码了?最后才意识到代码的本质是在操作结构化数据,是一脉相承的。

总结一下就是,我的判断往往比市场领先一年左右。这意味着,至少要持续负反馈状态下死磕大半年以上才有机会。比如 AI Coding 和MCP当时差不多都要等1年。

ZP:是的,即便方向对、需求真实,也需要经历至少半年的磨合期,才能看到一些正向信号。AI 不是一波流的生意,而是需要长期投入、厚积薄发,中间会有多个阶段性爆发。

王文锋:对。我觉得可以回头看看,成立半年内就迅速出的圈产品,几乎没有。现在那些明星产品,哪个没一两年的“冷板凳”?Cursor是22年成立,24年5月Claude 3.5出来后才开始起飞。再比如 Manus,先是Monica积累了两年,哪怕决定开始做Manus,也不是一帆风顺,中间半年多的时间也是调整了好几次。

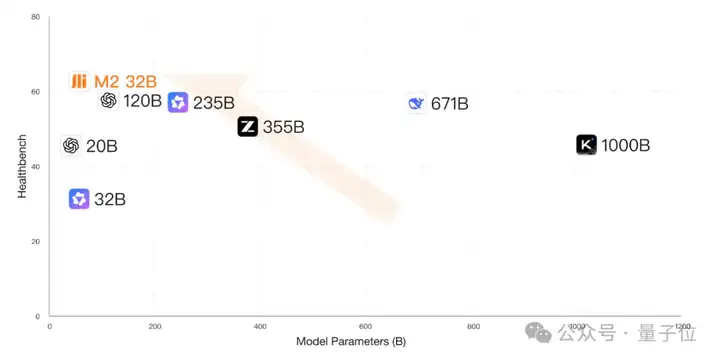

所以我的总结是:一是要有合理预期。尤其是不要低估作出Production-ready Agent的工程复杂度。正好前两天看到一个图,我觉得很贴切。

二是要还是对模型进步要有信心。这是个老生常谈的问题了,但每次模型发布,都会有很多人出来唱衰,我现在都是直接屏蔽这些言论。

我对模型的信心转折点是在 2025年5月的一天,之前我是一只强迫自己相信。当时是在和一个朋友聊天的时候,我脑子突然蹦出来一个想法:人类存在的本身是不是就是AGI存在的最好证明。因为人是大自然在复杂物理规律作用下的产物,人有智慧,所以从这个事实出发,智慧本身是物理规律作用的结果。

有一个词叫“心理障碍击碎效应”,说的是某个问题或极限被突破证明可行了以后,复现的难度会下降一大截,典型如马拉松。所以回到我前述哪个看起来有点奇怪逻辑,既然大自然已经给我们打了样,证明智慧的存在是物理规律,所以我们有什么理由去怀疑模型不持续进步呢?

Z Potentials:你最后会想要送给现在正在 AI 方向创业的读者一些什么话吗?

AI发展很快,大家都很FOMO,很多时候大家都是被推着走。我最近一直在提醒自己:当一个东西开始泛滥的时候,一定要从浪花里跳到岸上,想想什么是稀缺的?我希望下半年能有更多的时间来思考。

最后我们在非非非常积极的招聘,从Agent工程师、大模型算法、产品、增长都非常需要(包括联创也可以聊!),如果想一起来实现Sheet0.com的未来愿景,欢迎在我公众号:bet-on-agi后台留言“招聘”取得我联系方式。

请注意,本次访谈内容已经过编辑整理并已获得王文锋的认可,仅代表受访者个人观点。我们也欢迎读者通过留言互动,分享您对本访谈的看法。欲了解更多信息,敬请访问Sheet0官方网站https://www.sheet0.com/。

文章来自微信公众号 “ Z Potentials “