闻乐 发自 凹非寺

量子位 | 公众号 QbitAI

27M小模型超越o3-mini-high和DeepSeek-R1!推理还不靠思维链。

开发者是那位拒绝了马斯克、还要挑战Transformer的00后清华校友,Sapient Intelligence的创始人王冠。

这个27M小模型就是Sapient最新提出的开源可复现的分层推理模型Hierarchical Reasoning Model(下面简称HRM),模仿大脑的分层处理与多时间尺度运作机制,克服了标准Transfomer的计算局限。

2700万参数,就实现了对现有大模型的精准超车。

不用预训练补课,还不靠思维链打草稿,仅凭1000个训练样本,就把极端数独、30x30迷宫玩得明明白白。

甚至连衡量通用智能的ARC-AGI测试都能碾压一众参数规模更大、上下文更长的Claude 3.7等“大前辈”。

有网友感叹,这就像四两拨千斤AI版……

所以,HRM这个小模型是如何做到的?

核心是仿脑的双层循环模块设计

HRM之所以能有如此出色的表现,源于其五项核心技术的巧妙设计。

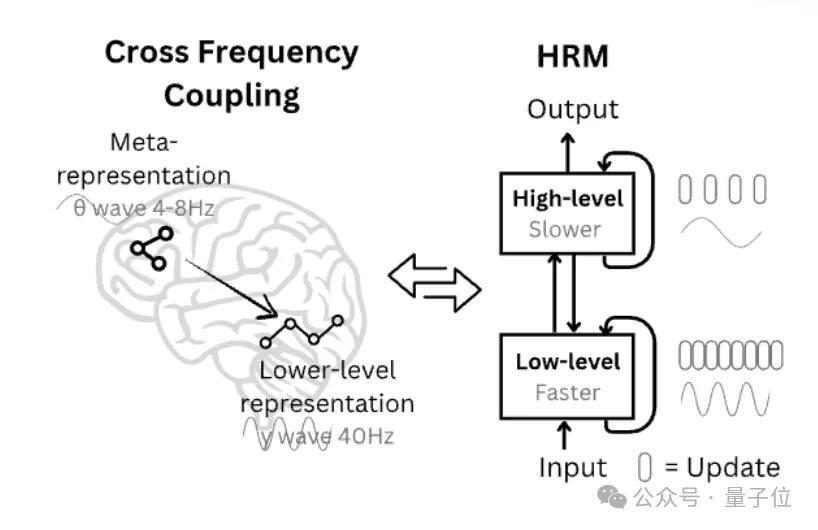

首先是分层循环模块与时间尺度分离。

HRM受大脑皮层区域分层处理和时间分离机制启发,设计了两个相互配合的循环模块:一个高层模块负责慢节奏的抽象规划,一个低层模块处理快节奏的细节计算,不用明确监督中间过程,一次就能完成推理。

两者在不同时间尺度上协同工作。低阶模块在每个高阶周期内完成多次计算并达到临时稳定状态后,高阶模块才会更新决策,随后低阶模块重置并开启新一轮计算。

这种设计既保证了全局方向的正确性,又提升了局部执行的效率。

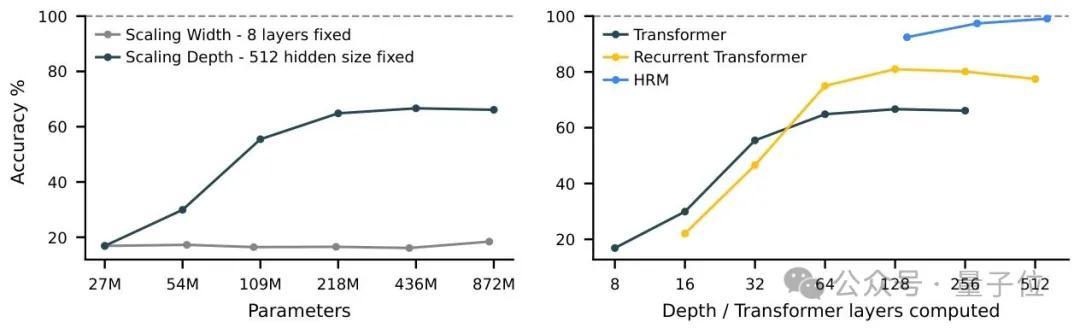

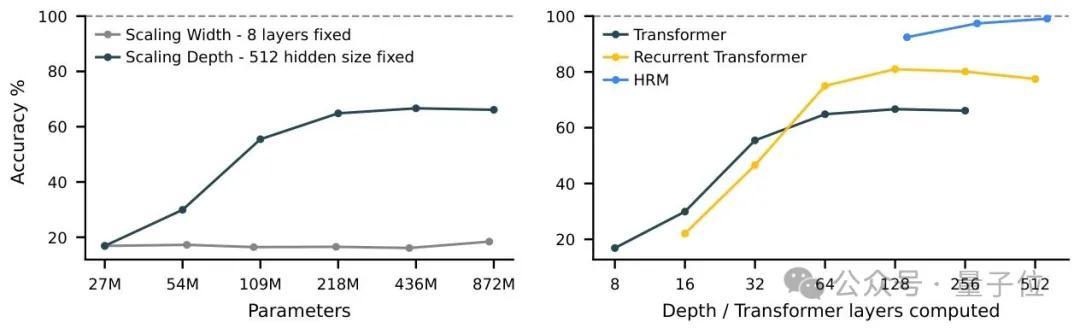

比如,在需要大量树搜索和回溯的Sudoku-Extreme Full任务上,增加Transformer的宽度不能提升性能,增加深度才是关键,而标准架构会出现性能饱和,无法从深度增加中获益。

HRM则克服了这一限制,能有效利用计算深度实现近乎完美的准确率。

其次是分层收敛机制。

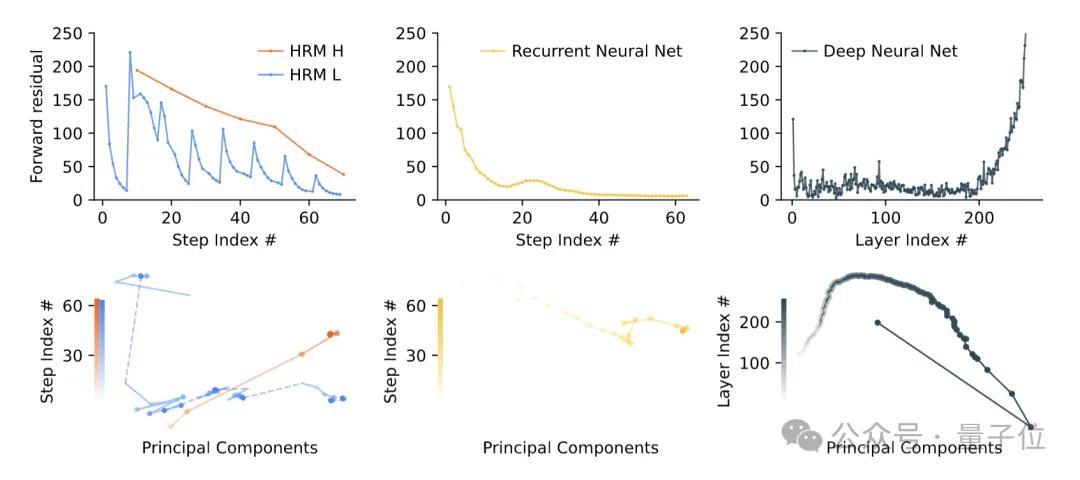

普通的循环神经网络常出现过早收敛的问题——计算几步就陷入稳定状态,后续再复杂的任务也无法推进。

而HRM中,低阶模块在每轮计算中会收敛到基于当前高阶状态的局部结果,但高阶模块更新后,会给低阶模块设定新的目标,使其进入新的收敛周期。

这就像完成项目时,先攻克一个子任务,再根据整体进度调整目标,确保持续推进不偷懒。

第三项是近似梯度技术。

传统循环模型训练时,需要存储所有中间状态并反向追溯,类似复盘时要回看每一步操作,既耗内存又低效。

HRM则采用一步梯度近似,只需根据最终状态反推优化方向,如同根据考试结果直接定位薄弱知识点,内存需求恒定且计算高效,更符合生物大脑的学习规律。

第四是深度监督机制。

它受大脑中神经振荡调节学习节奏的启发,引入了阶段性测试。

模型在学习过程中被分成多个阶段,每个阶段结束后立即评估并调整参数,且前后阶段的计算互不干扰。

这种方式能及时纠正偏差,就像学生每学一单元就测试巩固,比期末一次性考试的学习效果更扎实。

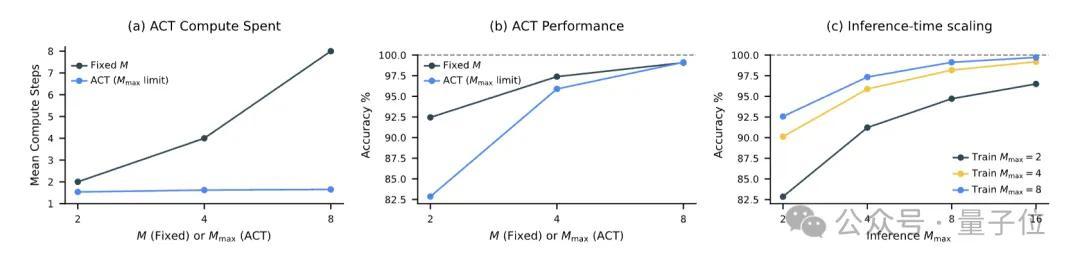

自适应计算时间让HRM能像人一样灵活分配思考时间。

它通过类似评估收益的算法(Q学习),动态决定是否继续计算,在保证准确率的同时避免算力浪费,推理时还能通过增加计算资源进一步提升表现。

比如,简单任务如简单迷宫快速给出答案,复杂任务如高难度数独则延长计算时间。

这些技术的融合,让HRM在多项测试中表现不凡。

下图通过可视化中间步骤,验证了HRM的分层推理机制能够有效拆解复杂任务,通过渐进式计算逼近正确结果,而非依赖黑箱式的一次性输出。

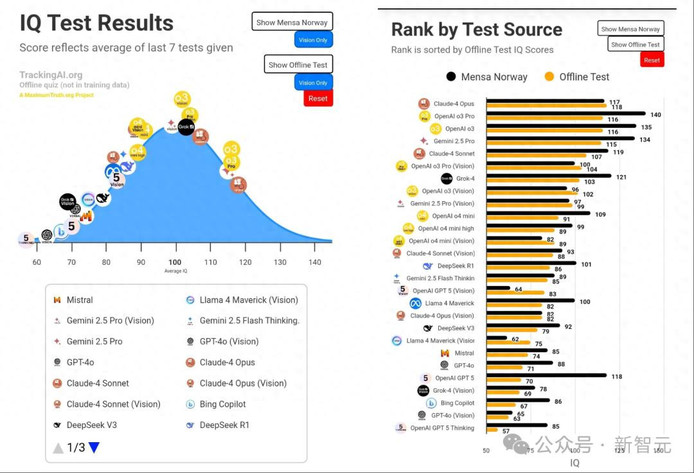

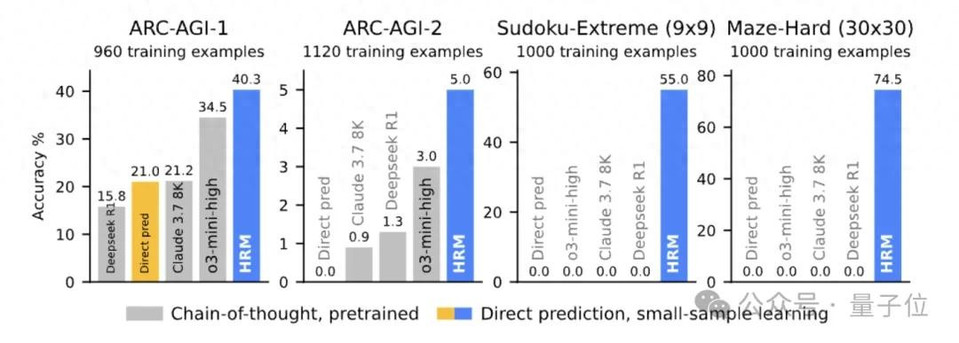

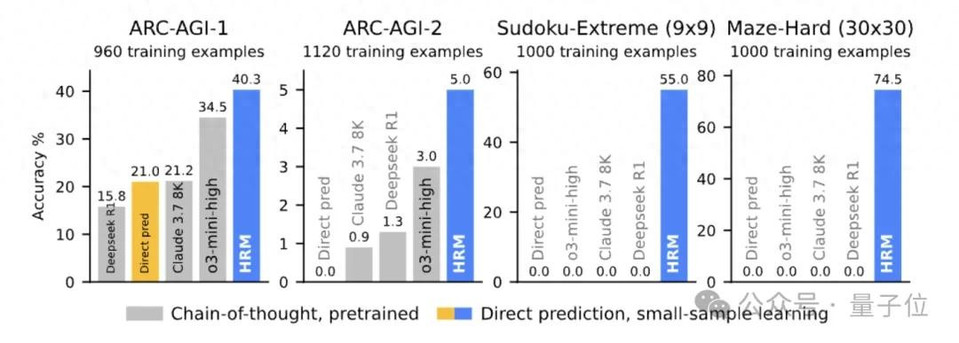

在衡量AI通用推理能力的ARC-AGI挑战中,HRM仅用2700万参数和1000个训练样本,就达到40.3%的准确率,超过了参数规模更大的o3-mini-high(34.5%)和Claude 3.7 8K(21.2%)。

对于需要反复试错的9x9极端数独,现有思维链模型完全无法解决(准确率0%),即便是结构相似的Transformer模型,用同样数据训练也毫无头绪。而HRM几乎能全部做对。

在30x30复杂迷宫的最优路径寻找任务中,HRM表现稳定,而1.75亿参数的大型Transformer模型准确率不足20%。

虽然,HRM被指参数太小、训练范围有限,只针对特定领域表现好,无法泛化到领域外,并不通用。但有人认为小而精的模型或许在某些角度上更智能。

人工智能的飞跃在于创造性。

也有人认为HRM的前景更在于“仿脑”,通过精心设计的高低两个模块避免过早收敛,对过拟合具有极强的抵抗力。

甚至有人相当乐观,认为这种新架构是神经网络一个巨大的进步。有可能是超越Transformer的时刻。

拒绝马斯克,挑战Transfomer

论文的第一作者王冠是一位00后,8岁开始学习编程,后保送至清华大学计算机系。

他是GitHub揽星5.1k开源项目OpenChat的独立开发者,独立完成了OpenChat全部版本的模型开发和训练框架搭建。

也正是因为OpenChat这个项目,他和马斯克产生了交集。

但他算得上是一个拒绝了马斯克的男人——此前,王冠多次拒绝了xAI等一线机构创始人的加入邀请。

原因是他认为自己要做的是颠覆Transfomer。

2024年,王冠和联合创始人Austin创办了Sapient Intelligence,并成功融资数千万美元。致力于打造“真正具有复杂推理和规划能力的全新大模型架构”。

论文地址:https://arxiv.org/abs/2506.21734

代码地址:https://github.com/sapientinc/HRM

参考链接:

[1]https://x.com/casper_hansen_/status/1951656675250684163

[2]https://x.com/deedydas/status/1951677875004100814

[3]https://x.com/omarsar0/status/1951751651729060081

— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一时间获知前沿科技动态