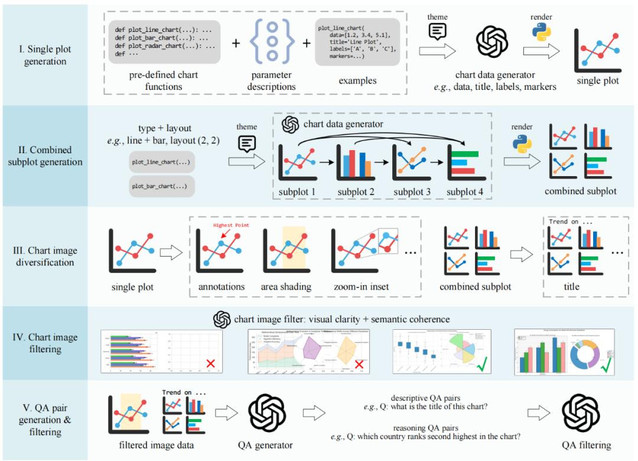

本文第一作者杨昱威,来自澳大利亚国立大学,合作者包括章泽宇(澳大利亚国立大学)、侯云钟(澳大利亚国立大学)、李卓婉(约翰霍普金斯大学)、Gaowen Liu(思科)、Ali Payani(思科)、丁源森(俄亥俄州立大学)以及郑良(澳大利亚国立大学)。

背景与动机

在科研、新闻报道、数据分析等领域,图表是信息传递的核心载体。要让多模态大语言模型(MLLMs)真正服务于科学研究,必须具备以下两个能力:

1. 精准识别与理解图表元素(如坐标轴、图例、数据点、标题等);

2. 对图表数据进行深度推理(如计算差值、比较趋势、跨子图推理等);

然而,即便是最先进的开源多模态大语言模型(MLLMs),在高难度科学图表理解基准测试上准确率依旧徘徊在 30%–50%。尽管合成数据集易于生成,但它们通常存在以下问题:

- 风格单一:缺乏视觉和内容多样性;

- 缺乏真实性:与真实图表的分布差异较大;

- 数据模式受限:生成的图表数据过于简单,无法模拟复杂场景;

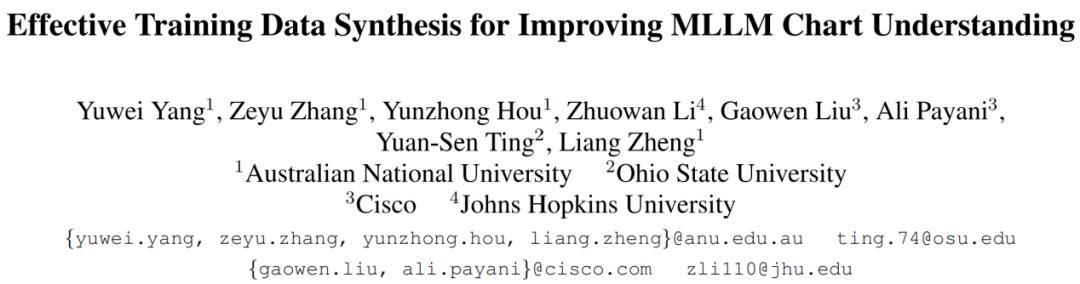

为此,我们提出 ECD(Effective Chart Dataset)—— 一个规模大、质量高、风格多样的合成图表数据集。同时,本文还配套设计了一条模块化数据合成流水线以及高质量评测基准 ECDBench,为开源 MLLM 提供全面的训练与评测支持。

- 论文标题:Effective Training Data Synthesis for Improving MLLM Chart Understanding

- 论文地址:https://arxiv.org/pdf/2508.06492

- 代码仓库:https://github.com/yuweiyang-anu/ECD

- 项目主页:https://effective-chart-dataset-synthesis.github.io

数据集亮点

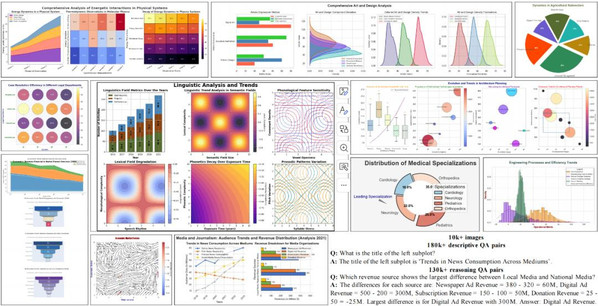

ECD 作为一个全新的高质量合成图表数据集,具备以下核心优势:

1. 数据规模与图表多样性

- 数据量:包含 10,000+ 图表,覆盖广泛的学科主题和图表类型;

- 多样性:涵盖 25 种主题(如经济学、天文学、医学等)、29 种图表类型(如线图、条形图、热力图等),以及 252 种子图组合(包括多种复杂布局,如 2 行 3 列、3 行 3 列布局等),是同类合成数据集中覆盖范围最广的。

2. 高质量问答对

数据集包含 300k+ 问答对(包括描述类和推理类问题),所有问答对均由 GPT-4o 自动生成并通过置信度过滤筛选得到。

示例:

描述类问题:“左侧子图的标题是什么?”

答案:“左侧子图的标题是‘不同媒介的消费趋势’ ”。

推理类问题:“哪个收入来源在本地媒体和国家媒体之间差异最大?”

答案:“数字广告收入差异最大,差值为 300M。”

3. 数据真实性

- 最低的 FID(Frechet Inception Distance)得分:ECD 数据集在视觉分布上与真实科学图表(如 CharXiv 数据集,从 arXiv 文章中图表搜集得到)的相似度最高;

- 最高的像素熵:平均像素熵显著高于其他合成数据集,表明其复杂度更高,信息量更大,推理难度也更高。

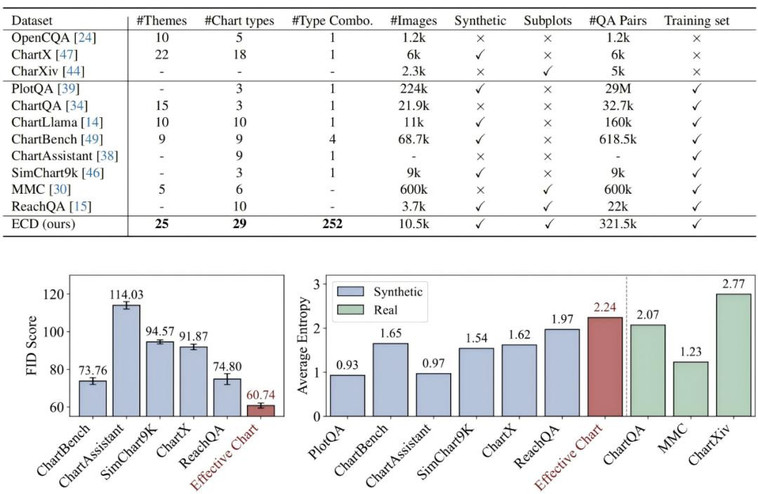

方法与创新:模块化五阶段数据合成流水线

为了实现高质量且多样化的合成图表数据集 ECD,本文设计了一个五阶段模块化的数据合成流水线,具体如下:

1. 单图生成

- 使用 29 种预定义绘图函数(如线图、饼图、散点图等),通过独立数据生成器生成数据表、标题、坐标轴标签、标记样式等内容;

- 数据生成与绘图代码生成分离,提升数据模式的多样性。数据可以随机选择生成递增、递减或波动等趋势。

2. 多子图组合

- 条件顺序生成,每个子图的数据生成需要参考前面子图的数据;

- 保证多子图之间的语义一致性,模拟真实科研图表的布局与信息关联。

3. 视觉多样化

- 添加注释、阴影、放大视窗(Zoom-in inset)、字体 / 坐标轴样式的变化;

- 引入 Seaborn 等绘图库,用于提升视觉丰富度;

- 调整图表的分辨率与比例,保证其内容可读性。

4. 图像质量过滤

- 基于 GPT-4o 对图表的视觉清晰度与语义连贯性进行两方面评分;

- 仅保留质量高于数据集平均评分的图表。

5. 问答对生成与过滤

- 每张图生成描述类与推理类两种类型的问答对;

- 通过 GPT-4o 进行置信度评分,保留置信度最高 QA,剔除低质量样本。

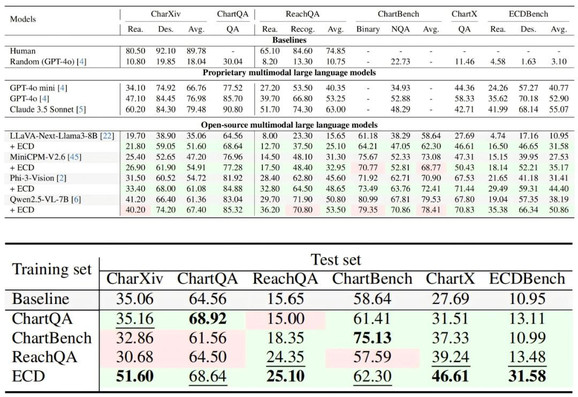

模型与训练集对比

- 在 6 个测试集上评估 4 个开源 MLLM,包括 LLaVA-Next-Llama3-8B、MiniCPM-V2.6、Phi-3-Vision 及 Qwen2.5-VL-7B。 实验表明,通过 ECD 训练集微调后,可一致提升 4 个开源 MLLM 的性能表现;

- 以 LLaVA-Next-Llama3-8B 为基线,对比先前 ChartQA、ChartBench、ReachQA 图表训练集 → 在 ECD 训练集监督微调训练(SFT)后,在所有测试集上均显著一致地提升基线性能,其余训练集上训练后模型性能存在较大波动(不同测试集上性能有提升 / 有下降)。

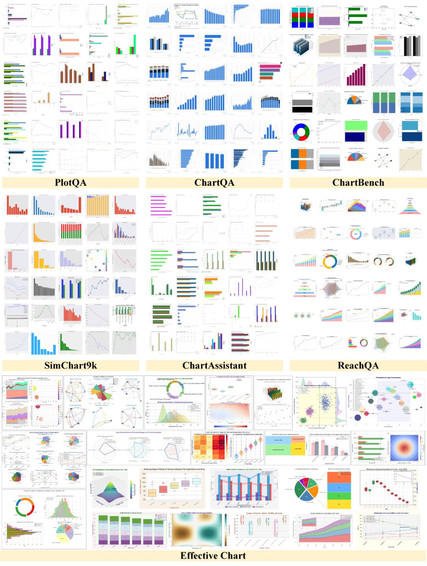

数据集可视化对比

ECDBench:高质量图表理解评测基准

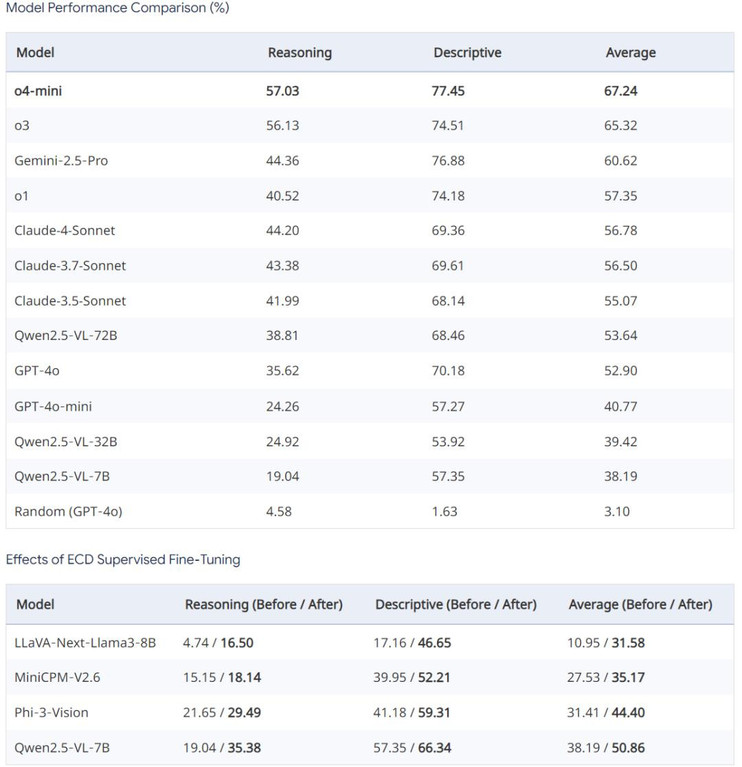

为进一步验证模型性能,我们基于所提出的 ECD 数据合成流水线与人工核对调整,额外构建了一个高质量的基准测试集 ECDBench,用于对当前多模态视觉语言模型以及采用我们 ECD 训练集监督微调前后的模型效果进行对比评估,基准统计信息如下:

- 规模:包含 1,224 张图表

- 组成:364 单图,860 多子图(涵盖 2–3 种图表类型)

- 平均分辨率:1378×968 px

- 数据来源:GPT4o 自动生成 + 人工精细修订

- QA 配置:每张图表生成 1 条描述类 + 1 条推理类问答,共计 2,448 对问答

ECDBench 上评估测试结果对比如下

在 ECDBench 上,所有衡量的 MLLMs 中,o4-mini 在所有三个指标上始终表现最佳(推理类问题准确率为 57.03%,描述类问题准确率为 77.45%,平均准确率为 67.24%)。另外,采用 ECD 训练集微调后的模型(如 LLaVA-Next-Llama3-8B)性能显著提升,表明 ECD 训练集的高质量问答对能够有效帮助提升模型图表理解能力。

总结与展望

ECD 通过模块化数据合成流程和高质量 QA 生成机制,保持了与真实科学图表的高相似度,且显著提升了数据多样性与复杂度。ECDBench 则为 MLLM 图表理解能力提供了全面的评测基准。我们相信,这一工作将为多模态推理、科学 AI 助手以及图表自动化生成领域提供坚实的数据基础与技术支持。