昨天夜里,深夜惊雷。

一个新团队突然发了一个首款通用行的项目:Manus。演示在此,我人直接看麻了。

看完我的第一感觉,卧槽,人类又要一败涂地了。

这尼玛,就是OpenAI的DeepResearch和Claude的Computer Use的究极集合体,甚至,他还能自己写代码,直接Coding Agent。

这特么是什么怪物啊。。。

我预想到这一天会来,只是没想到,来的如此之早。

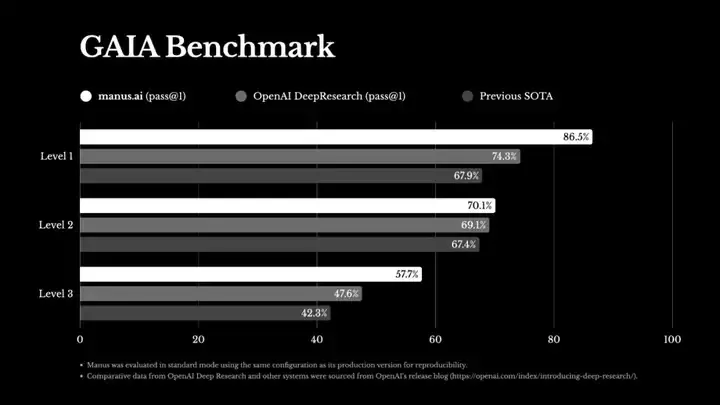

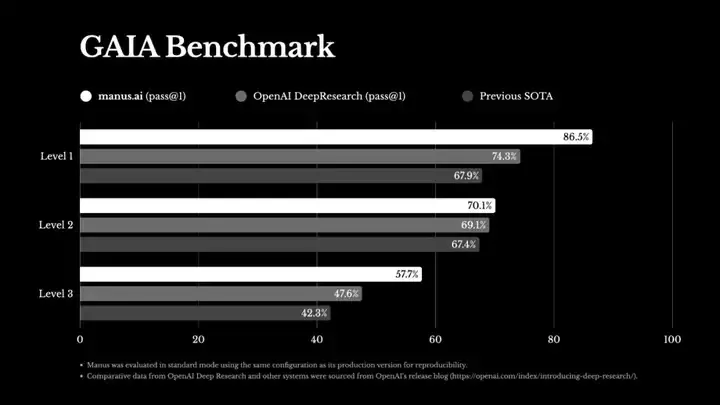

Manus在GAIA的评分上,也非常的离谱。

已经超越OpenAI的DeepResearch的了,成为GAIA评分第一。

可能很多人不知道GAIA是个啥,我简单说一下。

GAIA(General AI Assistants)是一个面向通用AI助手能力的基准评测体系,由 Meta AI(FAIR)、Hugging Face 等研究团队于 2023 年提出。

有一篇非常著名的论文:

里面有466个精心设计的问题。

传统的测试一般都是数学(AIME)或者一些专业知识问答、编程等等,但是GAIA测试,里面很多都是概念简单,但是需要多步骤解决的实际问题。

其中分为三个级别,Lv.1、Lv.2、Lv.3,难度依次递增。

想通过GAIA的测试,一般需要网络检索能力、工具调用能力、编程能力、文件处理能力等等。

在23年的时候,人类一般能达到90%的成功率,而那时候的最强AI GPT4,在第一级才勉强达到15%。

再看这张图,你就知道,有多强了。。。

说实话,我目前还愿意为ChatGPT每个月都氪200刀,主要就是o1 Pro和DeepResearch,这两玩意有一说一,在我做一些研究和需要强推理任务的时候,还是非常好用的。

而Manus这波,把DeepResearch干碎了,要知道,它之前已经是最强了。。。

Manus网址在此:https://manus.im

现在有个很难顶的问题是封测中,所以只有邀请码的用户才能体验到。

所以,我也动用了我的人脉,花了十分钟的时间,联系到了Manus团队的人,非常幸运的获得了邀请码。

不过,即使是没有拿到邀请码的用户,也可以去他们官网,大概看一下他们的Use Case,每一个,都非常的有意思。

而如果你有了邀请码,正常登录进去以后,就是一个大大的界面:

虽然都是一个对话框,但是Manus的能力还不太一样,他不是那个你提出个问题,AI一会就会直接给你回答Chatbot。

而是当你提出问题之后,他会根据你的问题和要求,来拆解任务,进行极度复杂的任务规划和执行。

并且会在云端自动运行,你可以直接退出出去,等运行完了,会通知你。

比如之前的那篇GAIA的论文,我想把PDF变成一个能拿出去讲的PPT,我把这个要求提给Manus的时候。

他会先把我的需求拆解。

我是这么说的:

1. 我希望你写一段Python程序,用OCR把这篇论文的PDF信息提取出来。

2. 将PDF里面的信息总结成PPT大纲。

3. 按照小米发布会的风格,做一份给普通人科普用的PPT。

4. 给我PPT的下载文件。

他会开始花一点时间来理解。

然后,在右边的窗口上,运行一个虚拟机,准备开始执行操作。

在虚拟机开启之后,会第一时间,列一份To Do List。

然后,就会开始执行第一个任务,安装python库。

完成的项目,会全部在右边的预览窗口打x。

他们用了一个非常有趣的交互形式,就是实时加进度同步。

右边的界面就像PPT一样,不断的下一页下一页,让你实时的看到,当前这个Manus正在做什么,你能看到它的每一点想法,每一个动作,这个掌控感真的太强了。

即使要等很久,你看着他在一点一点执行,这个感觉也真的很爽。

而右下角的任务步骤也可以展开,非常直观的告诉你,大步骤进行到哪一个阶段了。

交互做的极棒。

我这个case,只需要等大概几分钟以后,一个PPT就出来了。

看看PPT。

信息是没问题的,就是这美感= =还是欠缺了一点,但是在信息的排版和内容质量上,真的高到爆炸。

这个其实并不是特别能展示它的能力,我再展示另一个,我曾经试图让所有Agent尝试的例子,帮我整理发票。

我经常要出差,所以有一堆乱七八糟的发票需要让公司报销的,但是公司的大总管呢,制定了一个SOP,就是发票你不能直接打包给她,这样太乱,所以需要做成一个excel的模板,这样她好对账。

就是这样的,但是你知道,我要每个月把我的十几张发票,都处理成表格,真的很麻烦。

所以,当我抱着试试看的态度,把这个任务交给Manus的时候,我震惊了。

因为,它成功了。。。

我当时就浑身发麻了,实在太牛逼了。你们懂那种,浑身触电的感觉吗。

我给大家过一下流程。

最开始,我的Prompt超级简单。

就这么简简单单的一句话。

他在思考完以后,处理成了8步任务。

然后,解压压缩包,安装OCR依赖,提取发票,整理成表格等等等等。

我什么也没干,他就自己这么跑着。

9分钟以后,提示我任务完成了。

我一回来,就看到了了这个画面。

只有一个小地方没填上,其他都是对的。

太离谱了,这还需要人干吗?

我还用它,分析了一下阿里巴巴股票。

同样的case,我们先看看OpenAI的DeepResearch的结果。

质量是不错,很高,但是对比一下Manus,那可读性实在是有点不堪重负了。。。

Manus直接把任务拆解成了8步。

最重要的是,当他们完成的时候,所输出的内容。

当我看到所谓的报告,给出的是一个链接的时候,我就猜到,这个事情有点不简单了。

点进去以后,果然。。。

不仅图文并茂,这尼玛,这些图标图表居然是可以交互的。。。

我真的给跪了,我想给Manus磕一个。

然后今天QwQ不是开源了32B的推理模型吗,我又让Manus随手做了一个千问开源的时间线。

在经历了30多分钟后,一张时间线的地图就出来了。大家可以验证一下看看准不准。。。

我无话可说,人已跪地。

短短的几个小时的体验时间

人类真的即将,一败涂地。

在Manus的prompt技巧上,我自己试了下,你的点,一定要足够的清晰,描述越清晰具体,Manus 就能执行得越精准。

明确说明你的期望、格式要求和质量标准,可以大幅提升最终交付物的匹配度。

这一点,非常重要。

2025年3月6日,我觉得,即使在AI圈,也是一个值得铭记的日子。

阿里开源QwQ-32B,以如此尺寸在性能上追平DeepSeek R1满血版,另一边,Manus一夜崛起,把Agent工程带上了一个新的高度。

而这两个团队,都属于我们中国。

没错,都是中国团队。

为之自豪吧。

今夜的这一片星空,属于China。

宇宙,正在为我们而闪烁。

文章来自于“数字生命卡兹克”,作者“卡兹克”。