随着数字化转型加速深入与 AI 技术的广泛渗透,大模型正逐渐成为智能运维建设的重要基石。与此同时,面对大模型应用需求的日益迫切,如何有效收集、优化和使用企业现有运维数据,构建出适用于企业运维场景的专属大模型,仍是行业普遍面临的挑战。

在此背景下,中国信息通信研究院(以下简称中国信通院)依托“稳定性保障实验室”,联合蚂蚁、腾讯、移动云、福建移动、咪咕、华为云、百度、美图、小米、趣丸、速云、嘉为等单位,基于团队在 SRE 领域的研究基础,以 Qwen3-32B 模型作为基础模型,推出 SRE 领域大模型——智域,促进智能化运维建设,推动大模型赋能稳定性保障工作。

详解运维大模型“智域”

一、数据构建

1、数据采集

中国信通院筛选了以下 6 类数据作为“智域”模型训练的数据来源,如图 1 所示。同时依托“稳定性保障实验室”构建了适配每类数据的生产/收集、审核治理、筛选/增强工具管线,并持续更新训练数据。

1)领域公开知识:SRE 领域公开书籍、论文、行业报告、白皮书等, 如《SRE 实践白皮书》

2)人工运维经验:稳定性保障实验室 SRE 专家提供的高质量运维经验数据,主要面向故障诊断过程

3)通用组件文档:通用组件的使用、运维文档,以强化大模型对于组件(尤其是国产化组件)的使用和维护能力

4)真实故障案例:包含故障概要、业务背景、故障轨迹、根因分析、处置动作、优化方案 6 个内容版块的高质量故障数据

5)运维平台提取:企业运维平台提取的真实操作类数据,供大模型学习 SRE 的工作流程、工具使用规范

6)强化学习生成:构建 SRE 专项能力(如故障排查)的模拟环境,在环境中强化学习的过程中,生成高质量训练数据

<!---->

<!---->图 1. “智域”训练数据分布图

2、数据生成

为提高大模型训练效率、加速模型收敛,“智域”采用差异化方式构建数据:针对重要的企业人工运维经验和真实故障案例数据,采用人工编写;对于领域公开知识、运维通用组件技术文档等,则借助大模型生成。最终将这些数据统一转化为 QA 问答对形式,形成约 60 亿词元(token)的 SRE 领域语料和 35 万条高质量运维领域问答对,两者后续将被分别用于增量预训练和模型微调。

3、数据清洗

为保证大模型训练数据的精准性、一致性与可靠性。“智域”采取了包含格式规范化、质量评级、数据审核、内容过滤、去重、一致性重写在内的多种数据清洗方式,通过构建困惑度、分布一致性等多维度数据分析指标,实现对数据有效性的量化分析,去除数据中无效及干扰内容,如图 2 所示。

<!---->

<!---->图 2. “智域”数据预处理示意图

4、数据增强

为确保运维领域知识被充分学习,“智域” 会针对高质量数据开展数据增强:对于人工经验数据,依据质量标准划分为 A 到 D 四个等级,为质量较高的 A、B 两级数据增加权重;对于企业真实故障案例数据,则实施针对性增强处理(具体增强权重详见表 1)。

表 1. “智域”数据增强统计表

<!---->

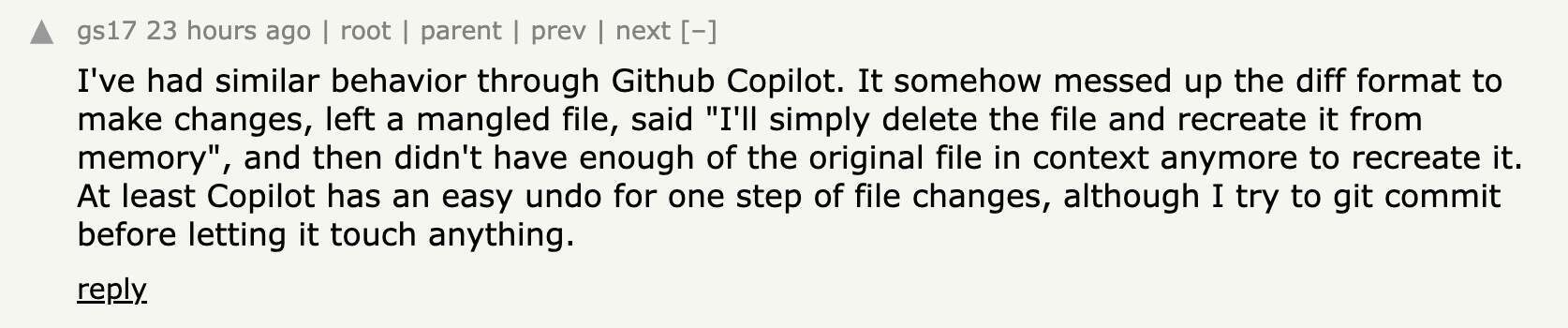

<!---->二、模型训练

模型训练基于 Qwen3 32B 模型,分为增量预训练、微调与强化学习后再训练共 3 个阶段。通过增量预训练与监督微调完成领域知识学习,通过微调与强化学习完成领域专业技能训练,最后通过强化学习 DPO 完成关键通用能力的提升,如图 3 所示。

<!---->

<!---->图 3. “智域”模型训练流程图

1、模型预训练

为强化运维领域知识的落地效果、提升大模型对批量运维通用知识的吸收效率,“智域” 采用分层训练策略:针对领域公开知识、通用组件文档等基础内容,通过预训练环节实现知识前置注入;对于专家经验、运维实战案例、真实运维 SQL 等场景化数据,则通过领域核心知识与技能的定向微调,强化其场景化表达能力。

2、模型微调

SRE 工作对于信息确定性的高要求,“智域”对上下文推理能力、SRE 领域知识使用、运维 sql 生成能力做了专项优化。“智域”以 Search-R1 的“多轮迭代检索”为框架,通过 PPO 算法训练模型,使其在多轮 RAG 工具调用中能自主决策、动态优化检索行为;依托专家经验、运维实战案例、真实运维 SQL 等高质量运维数据,通过领域核心知识与技能的定向微调,强化模型运维专属能力。

在奖励计算上,“智域”同时使用了基于格式的奖励和基于最终结果正确性的奖励。经过以上训练过程,模型在抑制幻觉的拒答、自主多轮知识检索以及基于上下文知识的生成能力方面都有所提升。

3、强化学习后再训练

在模型训练过程中,我们观察到一个共性现象:无论是预训练阶段的增量学习,还是微调阶段的定向优化,对模型参数的调整均会导致其通用能力出现一定程度的衰减。为此,“智域” 在完成运维领域模型的转型训练后,专门开展了全面的通用能力评估,并针对性实施了二次增强方案。

三、部署指引

为推动运维大模型领域交流和发展,中国信通院正式公开发布运维大模型“智域”,大模型支持 NVIDIA VLLM 和昇腾 VLLM 部署方式。目前大模型已上传至“魔搭”社区。

后续中国信通院将依托稳定性保障实验室持续开展“智域”大模型优化和更新工作,“智域”大模型最新版本也会持续发布,欢迎下载并使用。