阿里巴巴自然语言处理团队宣布推出WebWatcher,这是一个开源的多模态深度研究智能体,旨在突破现有闭源系统和开源Agent在多模态深度研究领域的局限性。WebWatcher通过整合网页浏览、图像搜索、代码解释器和内部OCR等多种工具,能够像人类研究员一样处理复杂的多模态任务,展现出强大的视觉理解、逻辑推理、知识调用、工具调度和自我验证能力。

WebWatcher的开发团队指出,尽管现有的闭源系统如OpenAI的DeepResearch在文本深度研究方面表现出色,但它们大多局限于纯文本环境,难以处理现实世界中复杂的图像、图表和混合内容。而现有的开源Agent也面临两大瓶颈:一类是专注于文本检索的Agent,虽然能够整合信息,但无法处理图像;另一类是视觉Agent,虽然能够识别图像,但缺乏跨模态推理和多工具协同能力。WebWatcher正是为了解决这些瓶颈而设计的。

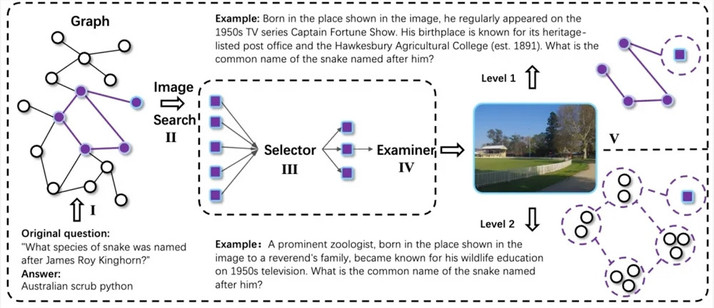

WebWatcher的技术方案覆盖了从数据构建到训练优化的完整链路,其核心目标是让多模态Agent在高难度多模态深度研究任务中具备灵活推理和多工具协作能力。为此,研究团队设计了一个全自动多模态数据生成流程,通过随机游走收集跨模态知识链,并引入信息模糊化技术,提升任务的不确定性和复杂性。所有复杂问题样本通过QA-to-VQA转换模块扩展为多模态版本,进一步增强了模型的跨模态理解能力。

在高质量推理轨迹构建与后训练方面,WebWatcher采用了Action-Observation驱动的轨迹生成方法,通过收集真实的多工具交互轨迹并进行监督微调(SFT),让模型在训练初期快速掌握多模态ReAct式推理和工具调用的基本模式。随后,模型进入强化学习阶段,通过GRPO进一步提升多模态Agent在复杂环境下的决策能力。

为了全面验证WebWatcher的能力,研究团队提出了BrowseComp-VL,这是BrowseComp在视觉-语言任务上的扩展版本,旨在逼近人类专家的跨模态研究任务难度。在多轮严格评测中,WebWatcher在复杂推理、信息检索、知识整合以及聚合类信息寻优等任务上全面领先于当前主流的开源与闭源多模态大模型。

具体来说,在人类终极考试(Humanity’s Last Exam,HLE-VL)这一多步复杂推理基准上,WebWatcher以13.6%的Pass@1分数一举夺魁,大幅领先于GPT-4o(9.8%)、Gemini2.5-flash(9.2%)和Qwen2.5-VL-72B(8.6%)等代表性模型。在更贴近真实多模态搜索的MMSearch评测中,WebWatcher的Pass@1得分高达55.3%,相比Gemini2.5-flash(43.9%)和GPT-4o(24.1%)大幅领先。在LiveVQA评测中,WebWatcher的Pass@1成绩达到58.7%,领先于其他主流模型。在最具综合挑战的BrowseComp-VL基准上,WebWatcher以27.0%的平均得分(Pass@1)遥遥领先,成绩提升超过一倍。

仓库地址:https://github.com/Alibaba-NLP/WebAgent