你可能听说过 deepseek-r1,但不知道它能不能跑在本地、更安全地“接网搜索”。这篇教程手把手教你如何在本地部署这款国产大模型,并打通联网搜索能力,构建自己的“小型AI问答系统”——从环境配置到调用细节,一步步跑通。

deepseek本地化部署,本地无限使用,token自由,随便用

不过本地部署吃本地电脑的硬件,响应没有直接使用网上的大模型反应快。

所需工具:

1、ollama

2、下载大模型(deep seek大模型)

3、安装大模型前端交互工具chatboxai

4、网页插件:实现联网搜索

接下来我来详细的介绍安装步骤:

第一步:下载ollama

认准这个羊驼图标。就是软件本体了

支持多种系统自行选择

我这下载的是windows版本

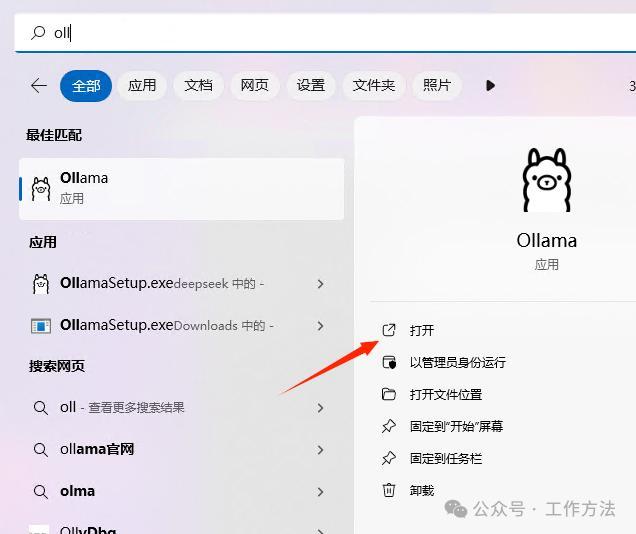

下载完成后,安装(一分钟基本上就安装完成了)

安装完成后运行软件:

运行后,系统右下角会有个图标,这就说明ollama

第二步:下载deepseek大模型

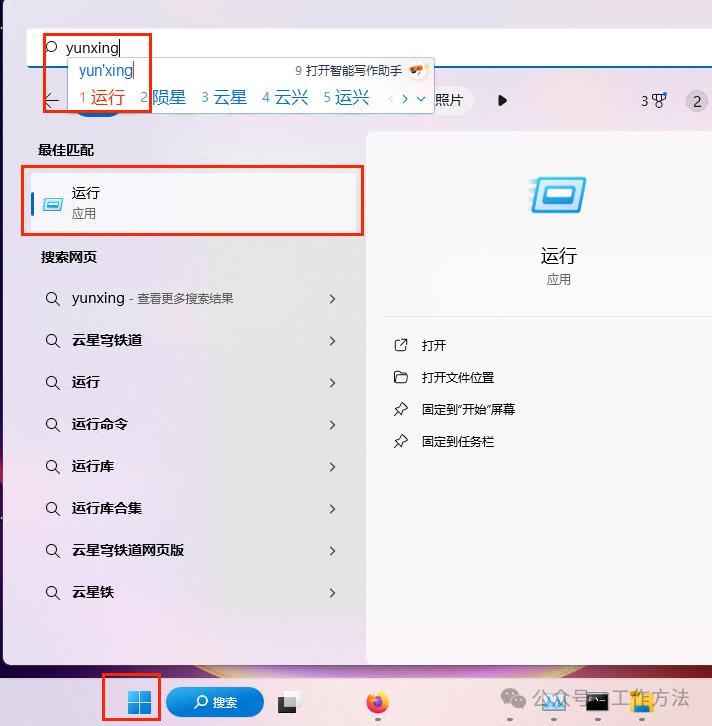

打开:“运行”,可以是win+r,或者在程序中搜索“运行”

然后就打开了这个

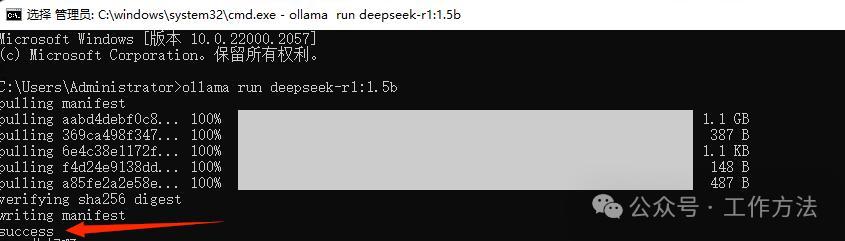

上图示意是下载的deepseek-R1:1.5B大模型

输入:ollama run deepseek-r1:1.5b

点击回车

等待十几分钟就可以下载完成了,

下载完成如下图

到此为止,大模型就是成功安装成功了,可以尝试对话使用了

比如下图,直接提问:

补充说明:不安装其他模型,可直接跳过。

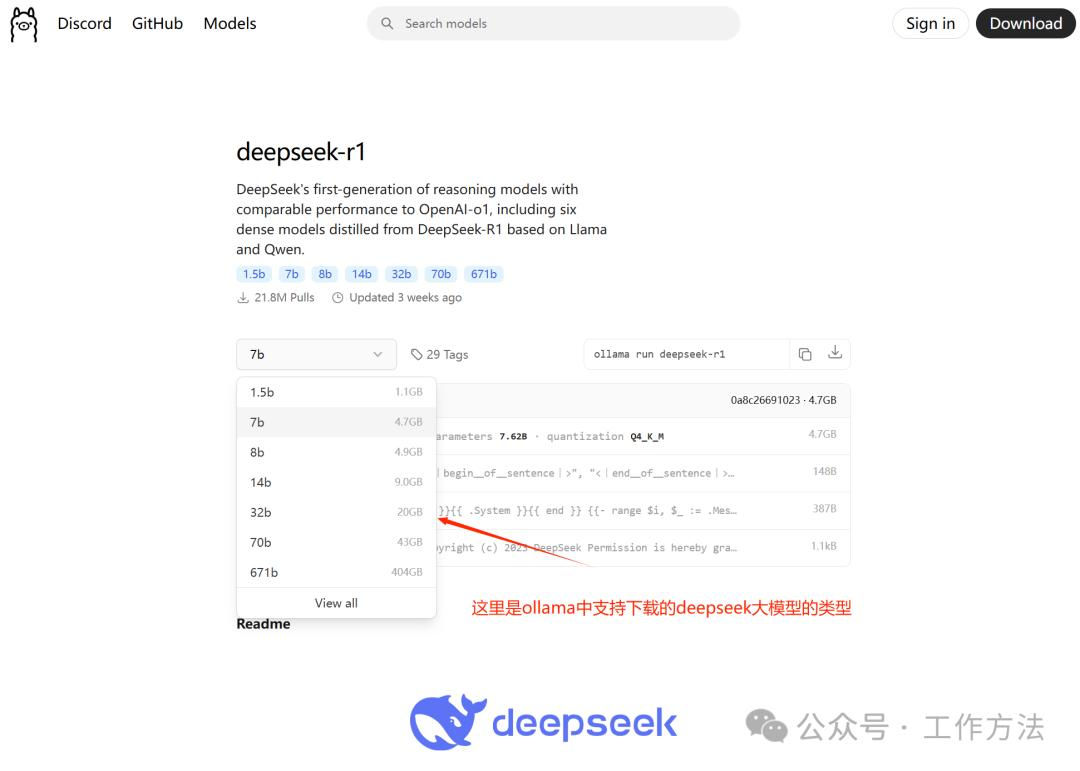

deepseek大模型有很多种,可自行选择下载,了解详情可点击ollama官网查看(

https://ollama.com/library/deepseek-r1)

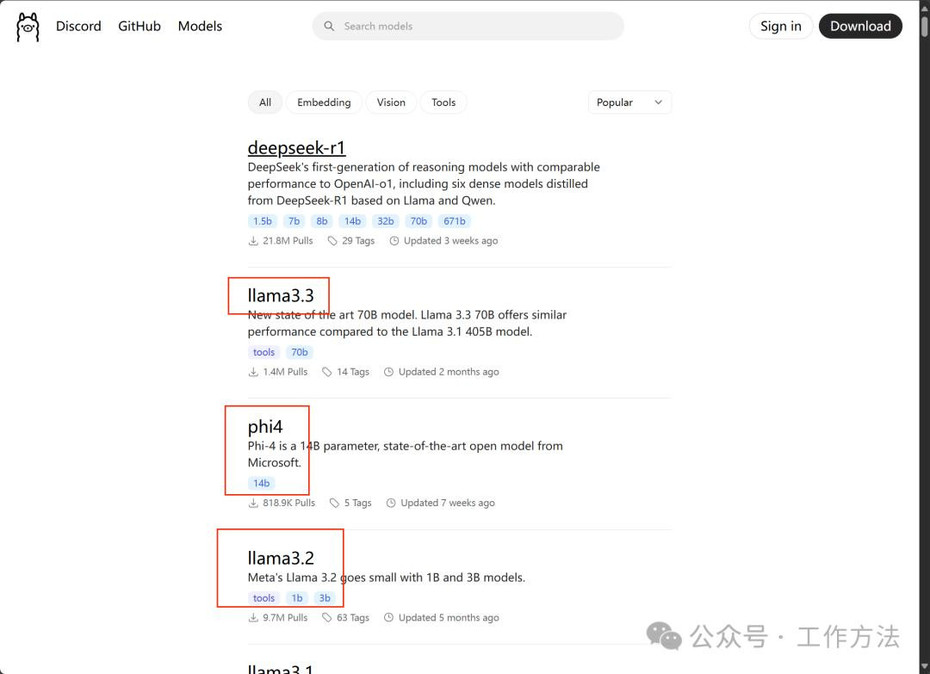

当然,ollama官网上还有其他大模型,也可尝试下载体验,原理是一样的,如下图

第三步:给eepseek大模型安装前端交互工具

这里用到的工具是chatboxai

选择合适自己的版本安装到本地就可以啦

下载完成后点击安装:

安装完成,运行即可

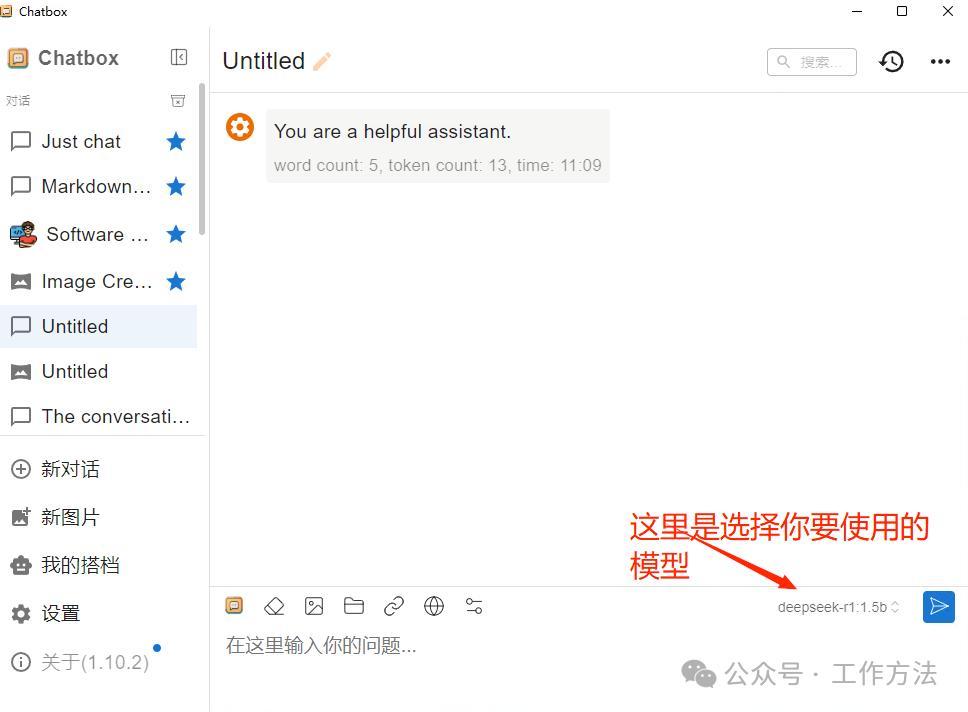

首次打开后,需要选择模型,选择一本地模型

保存后,点击左边的“新对话”选择使用模型

然后 就可以开启对话了(截止到目前,大模型+前端交互就完成,目前还不知持联网搜索)

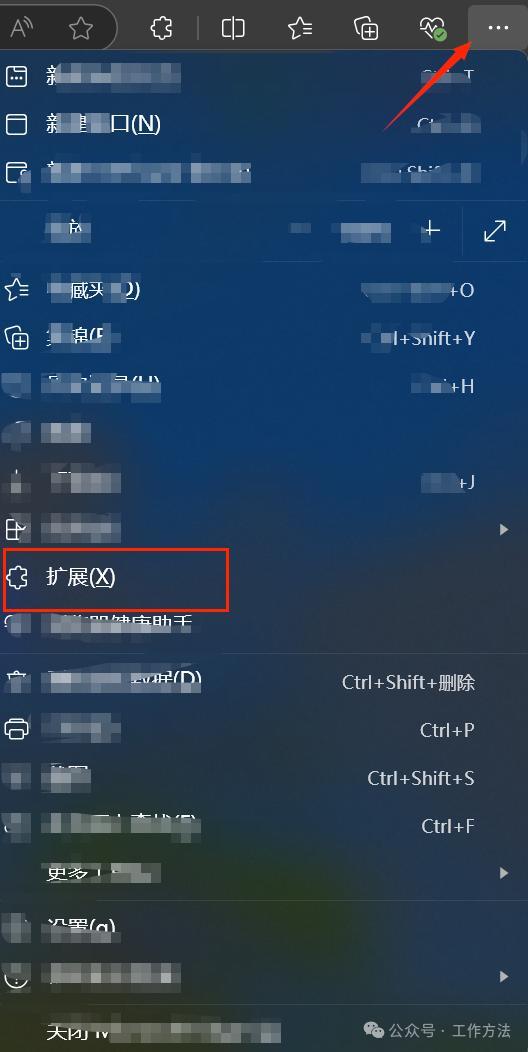

第三步:网页插件:实现联网搜索

这里用到浏览器插件:Page Assist – A Web UI for Local AI Models

你可用google、火狐、edge(推荐)

然后打开“拓展”

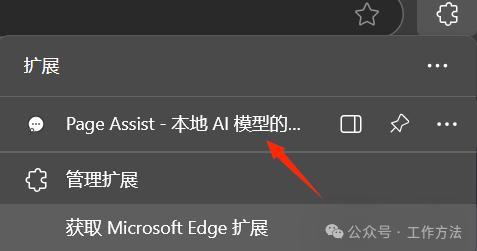

然后查找“Page Assist

点击安装

安装完成后如下:

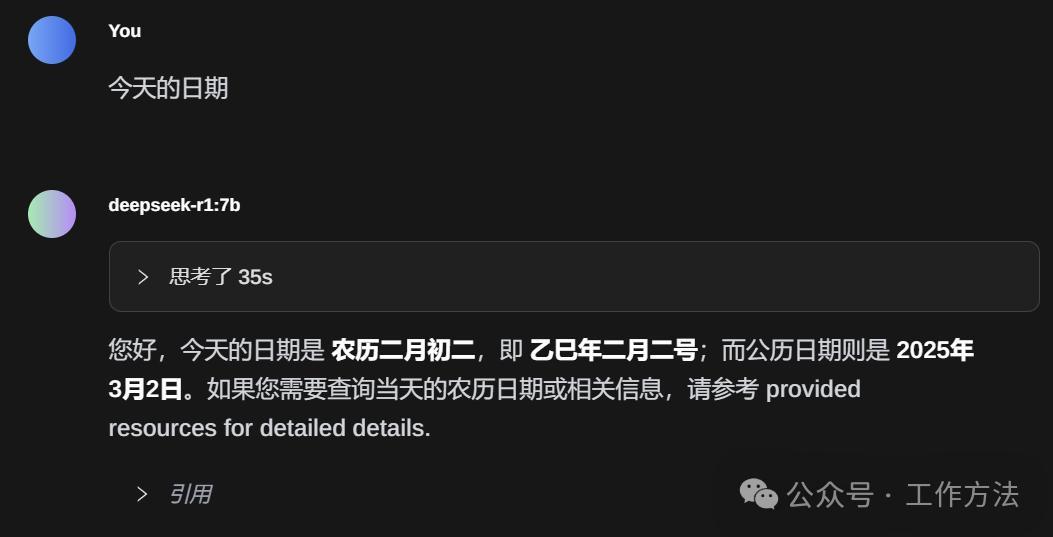

打开插件:

到这里,你就实现,本地化部署大模型+联网搜索的功能啦~

本文由 @董方旭 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务